Capítulo 4. Construir y ejecutar

Este trabajo se ha traducido utilizando IA. Agradecemos tus opiniones y comentarios: translation-feedback@oreilly.com

Nos deleitamos con la belleza de la mariposa, pero rara vez admitimos los cambios que ha sufrido para alcanzar esa belleza.

Maya Angelou

Construir y distribuir sistemas de software es complicado y caro: escribir código, compilarlo, probarlo, distribuirlo a un repositorio o a un entorno de preparación, y luego distribuirlo a producción para que lo consuman los usuarios finales. ¿Promover la resiliencia durante esas actividades no aumentará esa complejidad y esos gastos? En una palabra, no. Construir y entregar sistemas resistentes a los ataques no requiere conocimientos especiales de seguridad, y la mayor parte de lo que hace que un software sea "seguro" coincide también con lo que hace que un software sea de "alta calidad".

Como descubriremos en este capítulo, si podemos movernos con rapidez, sustituir con facilidad y apoyar la repetibilidad, podemos recorrer un largo camino para igualar la agilidad de los atacantes y reducir el impacto de los factores estresantes y las sorpresas -ya sean provocados por los atacantes o por otras influencias conspiradoras- en nuestros sistemas. Aunque este capítulo puede servir de guía para que los equipos de seguridad modernicen su estrategia en esta fase, nuestro objetivo en este capítulo es que los equipos de ingeniería de software o plataformas comprendan cómo pueden promover la resiliencia con sus propios esfuerzos. Necesitamos coherencia y repetibilidad. Tenemos que evitar tomar atajos sin perder velocidad. Necesitamos seguir innovando para crear más holgura en el sistema. Necesitamos cambiar para seguir siendo los mismos.

Cubriremos mucho terreno en este capítulo: ¡está repleto de sabiduría práctica! Después de hablar de los modelos mentales y las preocupaciones sobre la propiedad, inspeccionaremos el contenido mágico de nuestra poción de resiliencia para informarnos sobre cómo podemos construir y entregar sistemas de software resilientes. Consideraremos qué prácticas nos ayudan a cristalizar las funciones críticas del sistema y a invertir en su resistencia a los ataques. Exploraremos cómo podemos mantenernos dentro de los límites del funcionamiento seguro y ampliar esos umbrales para tener más margen de maniobra. Hablaremos de tácticas para observar las interacciones del sistema a través del espacio-tiempo y para hacerlas más lineales. Hablaremos de las prácticas de desarrollo que fomentan los circuitos de retroalimentación y una cultura de aprendizaje para que nuestros modelos mentales no se calcifiquen. Para terminar, descubriremos prácticas y pautas que nos mantengan flexibles, dispuestos y capaces de cambiar para apoyar el éxito de la organización a medida que el mundo evoluciona.

Modelos mentales en el desarrollo de software

En el último capítulo hablamos del buen diseño y la arquitectura desde la perspectiva de la resiliencia. Hay muchas formas de subvertir accidentalmente el diseño y la arquitectura resilientes una vez que empezamos a construir y entregar esos diseños. Ésta es la etapa en la que se reifican por primera vez las intenciones del diseño, porque los programadores deben tomar decisiones sobre cómo reifican el diseño, y estas decisiones también influyen en el grado de acoplamiento y complejidad interactiva del sistema. De hecho, los profesionales de todas las fases influyen en esto, pero trataremos cada una por separado en capítulos posteriores. Este capítulo explorará las numerosas compensaciones y oportunidades a las que nos enfrentamos cuando construimos y entregamos sistemas.

Esta fase -construir y entregar software- es uno de nuestros principales mecanismos de adaptación. En esta fase es donde podemos adaptarnos a medida que cambia nuestra organización, el modelo de negocio o el mercado. Es donde nos adaptamos a medida que nuestra organización escala. La forma de adaptarnos a estos factores de estrés crónicos suele ser construyendo un nuevo software, por lo que necesitamos la capacidad de traducir con precisión la intención de nuestra adaptación al nuevo sistema. La belleza de los experimentos de caos es que ponen al descubierto cuándo nuestros modelos mentales se alejan de la realidad. En esta fase, significa que tenemos una idea inexacta de lo que hace el sistema ahora, pero alguna idea -representada por nuestro diseño- de cómo queremos que se comporte en el futuro. Queremos viajar con seguridad desde el estado actual al estado futuro previsto.

En un mundo SCE, debemos pensar en términos de sistemas. Esto es parte de por qué esta fase se describe como "construir y entregar" y no sólo "desarrollar" o "codificar". Las interconexiones importan. El software sólo importa cuando está "vivo" en el entorno de producción y en el ecosistema de software más amplio. Que pueda sobrevivir en tu máquina local no significa que pueda sobrevivir en la naturaleza. Es cuando se entrega a los usuarios -de forma parecida a como describimos un nacimiento humano como un parto- cuando el software se vuelve útil, porque ahora forma parte de un sistema. Así que, aunque cubriremos las operaciones en el próximo capítulo, haremos hincapié en el valor de esta perspectiva de sistemas para los ingenieros de software que suelen centrarse más en la funcionalidad que en el entorno. Independientemente de que tus usuarios finales sean clientes externos u otros equipos internos (que siguen siendo en gran medida clientes), construir y ofrecer un sistema resistente requiere que pienses en su contexto final.

Los experimentos de caos de seguridad ayudan a los programadores a comprender el comportamiento de los sistemas que construyen en múltiples capas de abstracción. Por ejemplo, la herramienta de experimentación del caos kube-monkey borra aleatoriamente pods de Kubernetes ("k8s") en un clúster, exponiendo cómo los fallos pueden producirse en cascada entre aplicaciones en un sistema orquestado por k8s (donde k8s sirve como capa de abstracción). Esto es crucial porque los atacantes piensan a través de las capas de abstracción y explotan cómo se comporta realmente el sistema en lugar de cómo se pretende o está documentado que se comporte. Esto también es útil para depurar y probar hipótesis específicas sobre el sistema para refinar tu modelo mental del mismo y, por tanto, aprender lo suficiente para construir el sistema mejor con cada iteración.

¿A quién pertenece la seguridad de las aplicaciones (y la resiliencia)?

La SCE respalda que los equipos de ingeniería de software asuman la responsabilidad de construir y entregar software basado en patrones resistentes, como los que se describen en este libro. Esto puede adoptar varias formas en las organizaciones. Los equipos de ingeniería de software pueden autogestionarse por completo -un modelo totalmente descentralizado- en el que cada equipo proponga pautas basadas en la experiencia y acuerde cuáles deben convertirse en estándar (un modelo que probablemente sea el más adecuado para las organizaciones más pequeñas o nuevas). Otra opción es un modelo de asesoramiento: los equipos de ingeniería de software podrían aprovechar a los defensores como asesores que les ayuden a "desatascarse" o a superar mejor los retos de la resiliencia. Los defensores que lo hagan pueden ser el equipo de seguridad, pero también podrían ser fácilmente el equipo de SRE o de ingeniería de plataformas, que ya realiza actividades similares, aunque quizá no con la perspectiva de ataque actual. O, como trataremos en profundidad en el Capítulo 7, las organizaciones pueden elaborar un programa de resiliencia dirigido por un equipo de Ingeniería de Resiliencia de Plataforma que pueda definir directrices y patrones, así como crear herramientas que hagan que la forma resiliente sea la más conveniente para los usuarios internos.

Advertencia

Si tu organización tiene un modelo de defensa típico de -como un equipo de ciberseguridad independiente-, hay consideraciones importantes que debes tener en cuenta al pasar a un modelo de asesoramiento. Los defensores no pueden dejar que el resto de la organización se hunda o nade, declarando que la formación en concienciación sobre seguridad es suficiente; en el Capítulo 7 veremos por qué esto es cualquier cosa menos suficiente. Los defensores deben determinar, documentar y comunicar la capacidad de recuperación y las directrices de seguridad, permaneciendo accesibles como asesores para ayudar en la implementación cuando sea necesario. Esto se aleja del modelo tradicional de equipos de ciberseguridad que aplican políticas y procedimientos, y requiere un cambio de mentalidad de autócrata a diplomático.

El problema es que la seguridad tradicional de -incluido en su moderno maquillaje como "DevSecOps"- pretende microgestionar los equipos de ingeniería de software. En la práctica, los equipos de ciberseguridad suelen meterse en los procesos de ingeniería de software como pueden para controlar más y asegurarse de que se hace "bien", donde "bien" se ve exclusivamente a través de la lente de la optimización de la seguridad. Como sabemos por el mundo de la gestión organizativa, la microgestión suele ser señal de malos gestores, objetivos poco claros y una cultura de desconfianza. El resultado final es un acoplamiento cada vez más estrecho, una organización como un ouroboros.

El objetivo de un buen diseño y de las herramientas de la plataforma es hacer que la resiliencia y la seguridad pasen a un segundo plano y no a un primer plano. En un mundo ideal, la seguridad es invisible:el desarrollador ni siquiera es consciente de las cosas de seguridad que ocurren en segundo plano. Sus flujos de trabajo no parecen más engorrosos. Esto está relacionado con la mantenibilidad: no importa tu afán o tus nobles intenciones, las medidas de seguridad que impiden el trabajo en esta fase no son mantenibles. Como describimos en el último capítulo, nuestro propósito superior es resistir la gravedad de las presiones de producción que te arrastran a la Zona Peligrosa. Las organizaciones querrán que construyas más cosas de software más baratas y más rápidamente. Nuestro trabajo es encontrar un camino sostenible para ello. A diferencia de la infoseguridad tradicional, los programas de seguridad basados en la SCE buscan oportunidades para acelerar el trabajo de ingeniería de software, manteniendo al mismo tiempo la resiliencia, ya que la vía rápida será la que se utilice en la práctica, y hacer que la vía segura sea la vía rápida suele ser el mejor camino para ganar. Exploraremos esto a fondo en el Capítulo 7.

Es imposible que todos los equipos mantengan un contexto completo sobre todas las partes de los sistemas de tu organización. Pero el desarrollo resiliente depende de este contexto, porque la forma más óptima de construir un sistema para mantener la resiliencia -recuerda, resiliencia es un verbo- depende de su contexto. Si queremos sistemas resilientes, debemos fomentar la apropiación local. Los intentos de centralizar el control -como la ciberseguridad tradicional- sólo harán que nuestros sistemas sean frágiles porque ignoran el contexto local.

La determinación del contexto comienza con una misión lúcida: "El sistema funciona con la disponibilidad, velocidad y funcionalidad que pretendemos a pesar de la presencia de atacantes". Eso es realmente abierto, como debe ser. Para una empresa, la forma más eficaz de realizar esa misión es construir su aplicación para que sea inmutable y efímera. Para otra empresa, podría ser escribir el sistema en Rust1 (y evitar utilizar la palabra clave unsafe como escapatoria...2). Y para otra empresa, la mejor manera de cumplir esta misión es evitar la recopilación de datos sensibles, dejando que terceros se encarguen de ello y, por tanto, también de su seguridad.

Lecciones que podemos aprender de la administración de bases de datos al pasar a DevOps

La idea de que la seguridad pueda tener éxito mientras es "propiedad" de los equipos de ingeniería suele percibirse como un anatema para la infoseguridad. Pero ha ocurrido en otras áreas problemáticas complicadas, como la administración de bases de datos (DBA).

DBA se ha desplazado hacia el modelo "DevOps" (y, no, no se llama DevDBOps). Sin adoptar los principios DevOps, tanto la velocidad como la calidad se resienten debido a:

Desajuste entre responsabilidad y autoridad

Personal de operaciones de bases de datos sobrecargado

Ruptura de los circuitos de retroalimentación de la producción

Reducción de la productividad de los desarrolladores

¿Te suena? Al igual que el DBA, los programas de seguridad se sitúan tradicionalmente en un equipo central específico, separado de los equipos de ingeniería, y a menudo están reñidos con el trabajo de desarrollo. ¿Qué más podemos aprender sobre la aplicación de DevOps a DBA?

Los desarrolladores son dueños del esquema de la base de datos, la carga de trabajo y el rendimiento.

Los desarrolladores depuran, solucionan problemas y reparan sus propias averías.

Esquema y modelo de datos como código.

Existe un único canal de implementación totalmente automatizado.

La implementación de aplicaciones incluye migraciones automatizadas de esquemas.

Actualizaciones automatizadas de preproducción desde producción.

Existe automatización de las operaciones de la base de datos.

Estos atributos ejemplifican un paradigma descentralizado para el trabajo de base de datos. No hay un único equipo que "posea" el trabajo o la experiencia en bases de datos. Cuando algo va mal en una parte concreta del sistema, el equipo de ingeniería responsable de esa parte del sistema también es responsable de averiguar qué está fallando y solucionarlo. Los equipos aprovechan la automatización para el trabajo de base de datos, reduciendo la barrera de entrada y aligerando la carga cognitiva de los desarrolladores, lo que disminuye la necesidad desesperada de una profunda experiencia en bases de datos. Resulta que gran parte de la experiencia necesaria está envuelta en el trabajo duro; elimina las tareas manuales y tediosas y todo será más fácil para todos.

Merece la pena señalar que, en esta transformación, el trabajo y la complejidad no han desaparecido realmente (al menos, en su mayor parte); sólo se han automatizado en gran medida y se han ocultado tras las barreras de abstracción que ofrecen los proveedores de nube y SaaS. Y la mayor objeción a esta transformación -que arruinaría el rendimiento o dificultaría las operaciones- se ha demostrado (en su mayor parte) falsa. La mayoría de las organizaciones simplemente nunca se encuentran con problemas que pongan de manifiesto las limitaciones de este enfoque.

Como señala el ingeniero de datos y software Alex Rasmussen, ésta es la misma razón por la que SQL sobre almacenes en la nube ha sustituido en gran medida a los trabajos personalizados de Spark. Algunas organizaciones necesitan la potencia y flexibilidad que otorga Spark y están dispuestas a invertir el esfuerzo necesario para que tenga éxito. Pero la gran mayoría de las organizaciones sólo quieren agregar algunos datos estructurados y realizar algunas uniones. En este momento, hemos adquirido colectivamente una comprensión suficiente de este modo "común", por lo que nuestras soluciones dirigidas a este modo común son bastante sólidas. Siempre habrá casos atípicos, pero tu organización probablemente no sea uno de ellos.

También hay paralelismos con esta dinámica en la seguridad. ¿Cuánta gente hace su propio procesamiento de pagos en un mundo en el que abundan las plataformas de procesamiento de pagos? ¿Cuánta gente hace su propia autenticación cuando hay proveedores de plataformas de gestión de identidades? Esto también refleja el principio de "elegir lo aburrido" que tratamos en el último capítulo y que trataremos más adelante en este capítulo en el contexto de la construcción y la entrega. Debemos suponer que nuestro problema es aburrido a menos que se demuestre lo contrario.

Si adaptamos los atributos del DBA a la transformación DevOps para la seguridad, podrían ser algo así:

Los desarrolladores son dueños de los patrones de seguridad, la carga de trabajo y el rendimiento.

Los desarrolladores depuran, solucionan y reparan sus propias incidencias.

Políticas y normas de seguridad como código.

Existe un único canal de implementación totalmente automatizado.

La implementación de la aplicación incluye cambios automatizados en la configuración de seguridad.

Actualizaciones automatizadas de preproducción desde producción.

Automatización de las operaciones de seguridad.

No puedes lograr estos atributos a través de un equipo de seguridad que los gobierne a todos. La única forma de lograr esta alineación de responsabilidad y rendición de cuentas es descentralizando el trabajo de seguridad. Los programas de Campeones de la Seguridad representan una forma de empezar a descentralizar los programas de seguridad; las organizaciones que experimentaron con este modelo (como Twilio, cuyo estudio de caso sobre su programa se encuentra en el informe anterior de la SCE) están informando de resultados satisfactorios y de un ambiente de mayor colaboración entre la seguridad y la ingeniería de software. Pero los programas de Campeones de Seguridad son sólo un puente. Necesitamos un equipo dedicado a hacer posible la descentralización, por lo que dedicaremos todo el Capítulo 7 a la Ingeniería de Resiliencia de Plataformas.

¿Qué prácticas fomentan la resiliencia cuando se construye y entrega software? Ahora veremos qué prácticas fomentan cada ingrediente de nuestra poción de resiliencia.

Decisiones sobre la funcionalidad crítica antes de construir

¿Cómo cosechamos el primer ingrediente de la receta de nuestra poción de resiliencia -comprender la funcionalidad crítica del sistema- cuando construimos y entregamos sistemas? Bueno, probablemente deberíamos empezar un poco antes, cuando decidimos cómo implementar nuestros diseños de la fase anterior. Esta sección trata de las decisiones que debes tomar colectivamente antes de construir una parte del sistema y cuando lo reevalúes a medida que cambie el contexto. Cuando implementamos una funcionalidad crítica desarrollando código, nuestro objetivo es la simplicidad y la comprensibilidad de las funciones críticas; ¡el espíritu demoníaco de la complejidad puede asaltarnos para devorarnos en cualquier momento!

Una faceta de la funcionalidad crítica durante esta fase es que los ingenieros de software suelen estar construyendo y entregando parte del sistema, no el conjunto. Neville Holmes, autor de la columna "La profesión" en la revista Computer del IEEE, dijo: "En la vida real, los ingenieros deberían estar diseñando y validando el sistema, no el software. Si te olvidas del sistema que estás construyendo, el software a menudo será inútil". Perder de vista la funcionalidad crítica -a nivel de componente, pero sobre todo a nivel de sistema- nos llevará a asignar mal la inversión de esfuerzo y a echar a perder nuestra cartera.

¿Cuál es la mejor forma de asignar las inversiones de esfuerzo durante esta fase para garantizar que la funcionalidad crítica esté bien definida antes de que se ejecute en producción? Propondremos algunas oportunidades fructíferas -presentadas como cuatro prácticas- durante esta sección que nos permiten movernos con rapidez a la vez que sembramos semillas de resiliencia (y que apoyan nuestro objetivo de RAVE, del que hablamos en el Capítulo 2).

Consejo

Si formas parte de un equipo de seguridad o lo diriges, considera las oportunidades de este capítulo como prácticas que debes evangelizar en tu organización e invierte esfuerzos en facilitar su adopción. Es probable que quieras asociarte con quien establezca las normas dentro de la organización de ingeniería para hacerlo. Y cuando elijas proveedores que apoyen estas prácticas y patrones, incluye a los equipos de ingeniería en el proceso de evaluación.

Los equipos de ingeniería de software pueden adoptarlas por su cuenta. O bien, si existe un equipo de ingeniería de plataformas, pueden esforzarse para que estas prácticas se adopten lo más fácilmente posible en los flujos de trabajo de ingeniería. Hablaremos más del enfoque de ingeniería de plataformas en el Capítulo 7.

En primer lugar, podemos definir los objetivos y directrices del sistema utilizando el "enfoque de la esclusa". En segundo lugar, podemos llevar a cabo revisiones reflexivas del código para definir y verificar las funciones críticas del sistema mediante el poder de los modelos mentales en competencia; si alguien está haciendo algo raro en su código -lo que debería señalarse durante la revisión del código de un modo u otro-, probablemente se reflejará en las propiedades de resiliencia de su código. En tercer lugar, podemos fomentar el uso de patrones ya establecidos en el sistema, eligiendo tecnología "aburrida" (una iteración sobre el tema que exploramos en el último capítulo). Y, por último, podemos estandarizar las materias primas para liberar capital de esfuerzo que pueda invertirse en otras cosas para la resiliencia.

Veamos cada una de estas prácticas por separado.

Definición de objetivos del sistema y directrices sobre "qué tirar por la esclusa"

Una práctica para apoyar la funcionalidad crítica durante esta fase es lo que llamamos el "enfoque de la esclusa": siempre que estemos construyendo y entregando software, tenemos que definir lo que podemos "tirar por la esclusa". ¿Qué funcionalidades y componentes puedes descuidar temporalmente y que el sistema siga realizando sus funciones críticas? ¿Qué te gustaría poder desatender durante un incidente? Sea cual sea tu respuesta, asegúrate de que construyes el software de forma que puedas desatender esas cosas cuando sea necesario. Esto se aplica tanto a los incidentes de seguridad como a los de rendimiento; si un componente se ve comprometido, el enfoque de la esclusa te permite desconectarlo si no es crítico.

Por ejemplo, si el procesamiento de transacciones es la función crítica de tu sistema y la elaboración de informes no lo es, debes construir el sistema de modo que puedas tirar los informes "por la esclusa" para preservar recursos para el resto del sistema. Es posible que la presentación de informes sea extremadamente lucrativa -tu impresora de dinero más prolífica- y, sin embargo, como la puntualidad de la presentación de informes importa menos, aún puede sacrificarse. Es decir, para mantener la seguridad del sistema y la exactitud de los informes, sacrificas el servicio de informes durante un escenario adverso -aun siendo el servicio más valioso- porque su funcionalidad crítica aún puede mantenerse con un retraso.

Otra ventaja de definir las funciones críticas con la mayor precisión posible es que podemos limitar el tamaño de los lotes, una dimensión importante de nuestra capacidad para razonar sobre lo que estamos construyendo y entregando. Garantizar que los equipos puedan seguir el flujo de datos en un programa de su competencia ayuda a evitar que los modelos mentales se alejen demasiado de la realidad.

Este enfoque despiadado en la funcionalidad crítica puede aplicarse también a niveles más locales. Como comentamos en el último capítulo, tender hacia componentes de propósito único infunde más linealidad al sistema, y nos ayuda a comprender mejor la función de cada componente. Si la función crítica de nuestro código sigue siendo elusiva, ¿para qué lo escribimos?

Revisiones del código y modelos mentales

Las revisiones del código nos ayudan a verificar que la implementación de nuestra funcionalidad crítica (y no crítica también) se ajusta a nuestros modelos mentales. Las revisiones del código, en el mejor de los casos, implican que un modelo mental proporciona información sobre otro modelo mental. Cuando reificamos un diseño a través del código, estamos instanciando nuestro modelo mental. Cuando revisamos el código de otra persona, construimos un modelo mental del código y lo comparamos con nuestro modelo mental de la intención, proporcionando retroalimentación sobre cualquier cosa que se desvíe (u oportunidades para refinarlo).

En los flujos de trabajo modernos de desarrollo de software, las revisiones del código de suelen realizarse tras el envío de una solicitud pull (PR). Cuando un desarrollador cambia el código localmente y quiere fusionarlo con la base de código principal (conocida como "rama principal"), abre un PR que notifica a otro humano que esos cambios -denominados "commits"- están listos para ser revisados. En un modelo de integración continua y despliegue/entrega continuos (CI/CD), todos los pasos de las pull requests, incluida la fusión de los cambios en la rama principal, están automatizados, excepto la revisión del código.

En relación con el modelo de cambio iterativo que discutiremos más adelante en el capítulo, también queremos que nuestras revisiones de código sean pequeñas y rápidas. Cuando se envía el código, el desarrollador debe recibir comentarios pronto y con rapidez. Para garantizar que el revisor pueda ser rápido en su revisión, los cambios deben ser pequeños. Si a un revisor se le asigna un RP que incluye muchos cambios a la vez, puede haber un incentivo para hacer recortes. Pueden limitarse a hojear el código, comentar "lgtm" (a mí me parece bien), y pasar al trabajo que perciben como más valioso (como escribir su propio código). Al fin y al cabo, no obtendrán una bonificación ni ascenderán por hacer revisiones de código concienzudas; es mucho más probable que reciban recompensas por escribir código que aporte cambios valiosos a la producción.

A veces, las funciones críticas se pasan por alto durante la revisión del código porque nuestros modelos mentales, como comentamos en el último capítulo, son incompletos. Como descubrió un estudio, "la lógica de gestión de errores a menudo es simplemente errónea", y una simple comprobación de la misma evitaría muchos fallos críticos de producción en los sistemas distribuidos.3 También necesitamos revisiones de código para las pruebas, en las que otras personas validen las pruebas que escribimos.

Advertencia

Las revisiones formales del código suelen proponerse tras un incidente notable, con la esperanza de que un acoplamiento más estricto mejore la seguridad (no lo hará). Si el código de una revisión ya está escrito y tiene un volumen importante, tiene muchos cambios o es muy complejo, ya es demasiado tarde. El autor del código y el revisor sentados juntos para discutir los cambios (frente al modelo asíncrono e informal que es mucho más común) parece que podría ayudar, pero es sólo "teatro de revisión". Si tenemos características mayores, deberíamos utilizar el modelo de "rama de características" o, mejor aún, asegurarnos de realizar una revisión del diseño que informe sobre cómo se escribirá el código.

¿Cómo incentivamos las revisiones de código concienzudas? Hay algunas cosas que podemos hacer para disuadir de tomar atajos, empezando por asegurarnos de que las herramientas se encargan de todos los detalles. Los ingenieros nunca deberían tener que señalar problemas de formato o espacios finales; cualquier problema de estilo debería comprobarse automáticamente. Garantizar que las herramientas automatizadas se encarguen de este tipo de trabajo sucio y quisquilloso permite a los ingenieros centrarse en actividades de mayor valor que pueden fomentar la resistencia.

Advertencia

Hay muchos antipatrones de revisión de código que, por desgracia, son comunes en el statu quo de la ciberseguridad, a pesar de que los equipos de ingeniería de seguridad son posiblemente los que más lo sufren. Un antipatrón es el requisito estricto de que el equipo de seguridad apruebe cada RP para evaluar su "peligrosidad". Aparte de la nebulosidad del término " peligrosidad", también existe el problema de que el equipo de seguridad carece de contexto relevante para los cambios de código.

Como sabe muy bien cualquier ingeniero de software, un equipo de ingeniería no puede revisar eficazmente los RP de otro equipo. Tal vez el ingeniero de almacenamiento podría pasarse una semana leyendo los documentos de diseño del equipo de ingeniería de redes y luego revisar un RP, pero nadie lo hace. Desde luego, un equipo de seguridad no puede hacerlo. Puede que el equipo de seguridad ni siquiera entienda las funciones críticas del sistema y, en algunos casos, puede que ni siquiera sepa lo suficiente sobre el lenguaje de programación como para identificar posibles problemas de forma significativa.

Como resultado, el equipo de seguridad puede convertirse a menudo en un estrecho cuello de botella que ralentiza el ritmo de cambio del código, lo que, a su vez, perjudica la resiliencia al dificultar la adaptabilidad. Esto suele parecer miserable también para el equipo de seguridad, y sin embargo los líderes suelen sucumbir a la creencia de que existe un binario entre los extremos de revisiones manuales y "dejar que los problemas de seguridad se escapen de las manos". Sólo un Sith trata con absolutos.

La tecnología "aburrida" es una tecnología resistente

Otra práctica que puede ayudarnos a refinar nuestras funciones críticas y priorizar el mantenimiento de su resistencia a los ataques es elegir tecnología "aburrida". Como se expone en el famoso post del ejecutivo de ingeniería Dan McKinley, "Elige tecnología aburrida", lo aburrido no es intrínsecamente malo. De hecho, lo aburrido probablemente indica capacidades bien comprendidas, lo que nos ayuda a manejar la complejidad y reducir la preponderancia de "interacciones desconcertantes" en nuestros sistemas (tanto el sistema como nuestros modelos mentales se vuelven más lineales).

En cambio, la tecnología nueva y "sexy" se comprende menos y es más probable que provoque sorpresas y desconciertos. El perímetro sangrante es un nombre apropiado dado el dolor que puede infligir cuando se implementa: al principio puede parecer sólo una herida superficial, pero a la larga puede drenar tu energía cognitiva y la de tus equipos. En efecto, estás añadiendo tanto un acoplamiento más estrecho como complejidad interactiva (linealidad decreciente). Si recuerdas el último capítulo, elegir "aburrido" nos proporciona una comprensión más amplia, que requiere menos conocimientos especializados -una característica de los sistemas lineales-, al tiempo que fomenta un acoplamiento más suelto de diversas maneras.

Por tanto, cuando recibas un diseño bien pensado (¡como uno basado en las enseñanzas del Capítulo 3!), considera si las elecciones de codificación, construcción y entrega que haces están añadiendo complejidad adicional y un mayor potencial de sorpresas, y si te estás vinculando estrechamente a ti mismo o a tu organización a esas elecciones. Los ingenieros de software deberían elegir el software -lenguajes, marcos, herramientas, etc.- que mejor resuelva los problemas empresariales específicos. Al usuario final realmente no le importa que hayas utilizado la última y mejor herramienta que se promociona en HackerNews. El usuario final quiere utilizar tu servicio cuando quiera, tan rápido como quiera y con la funcionalidad que quiera. A veces, resolver esos problemas empresariales requerirá una tecnología nueva y extravagante si te concede una ventaja sobre tus competidores (o si cumple de algún otro modo la misión de tu organización). Aun así, ten cuidado con la frecuencia con que buscas tecnología "no aburrida" para diferenciarte, pues el perímetro sangrante requiere muchos sacrificios de sangre para mantenerse.

Advertencia

Una bandera roja que indica que tu arquitectura de seguridad se ha desviado del principio de "elige lo aburrido" es si es probable que tus modelos de amenaza sean radicalmente distintos de los de tus competidores. Aunque la mayoría de los modelos de amenazas serán diferentes -porque pocos sistemas son exactamente iguales-, es raro que dos servicios que realizan la misma función por parte de organizaciones con objetivos similares parezcan extraños. Una excepción podría ser si tus competidores están atrapados en la edad oscura de la seguridad, pero tú persigues la seguridad por diseño.

Durante la fase de construcción y entrega, debemos tener cuidado con cómo priorizamos nuestros esfuerzos cognitivos, además de cómo gastamos los recursos de forma más general. Puedes gastar tus recursos finitos en una nueva herramienta muy ingeniosa que utilice IA para escribir pruebas unitarias por ti. O puedes gastarlos en crear una funcionalidad compleja que resuelva mejor un problema para los usuarios finales a los que te diriges. Lo primero no sirve directamente a tu negocio ni te diferencia; añade una importante sobrecarga cognitiva que no sirve a tus objetivos colectivos a cambio de un beneficio incierto (que sólo llegaría tras un doloroso proceso de ajuste y tirarse de los pelos a partir de unos documentos mínimos de resolución de problemas).

"Vale", dirás, "¿pero y si la cosa nueva y brillante es realmente genial?". ¿Sabes a quién más le gusta el software realmente guay, nuevo y brillante? A los atacantes. Les encanta que los desarrolladores adopten nuevas herramientas y tecnologías que aún no se conocen bien, porque eso crea muchas oportunidades para que los atacantes se aprovechen de los errores o incluso de la funcionalidad prevista que no se ha comprobado suficientemente contra el abuso. Los investigadores de vulnerabilidades también tienen currículos, y parecen impresionantes cuando pueden demostrar la explotación contra la cosa nueva y reluciente (lo que normalmente se conoce como "poseer" la cosa). Una vez que publican los detalles de cómo explotaron la nueva cosa brillante, los atacantes criminales pueden averiguar cómo convertirlo en un ataque repetible y escalable (completando el Fun-to-Profit Pipeline de la infoseguridad ofensiva).

Herramientas de seguridad y observabilidad tampoco están exentas de este principio de "elige lo aburrido". Independientemente de tu título "oficial" -y de si eres líder, gestor o colaborador individual-, debes elegir y fomentar herramientas de seguridad y observabilidad sencillas y bien comprendidas que se adopten en todos tus sistemas de forma coherente. A los atacantes les encanta encontrar implementaciones "especiales" de herramientas de seguridad u observabilidad y se enorgullecen de derrotar a las nuevas y relucientes mitigaciones que se jactan de derrotar a los atacantes de una forma u otra.

Muchas herramientas de seguridad y observabilidad requieren permisos especiales (como ejecutarse como root, administrador o administrador de dominio) y un amplio acceso a otros sistemas para realizar su supuesta función, lo que las convierte en herramientas fantásticas para que los atacantes obtengan un acceso profundo y potente a través de tus sistemas críticos (porque esos son los que especialmente quieres proteger y monitorizar). Una nueva y reluciente herramienta de seguridad puede decir que las matemáticas de fantasía resolverán todos tus problemas de ataque, pero esta fantasía es lo contrario de aburrida y puede engendrar una variedad de dolores de cabeza, incluyendo el tiempo necesario para ponerla a punto de forma continua, cuellos de botella en la red debido al acaparamiento de datos, pánicos en el kernel o, por supuesto, una vulnerabilidad en ella (o en su colección de fantasía y en sus canales impulsados por la IA, de empuje de reglas) que puede ofrecer a los atacantes un punto de apoyo encantador en todos los sistemas que te importan.

Por ejemplo, puedes tener la tentación de "hacer tu propia" autenticación o protección contra falsificación de petición en sitios cruzados (XSRF). Fuera de los casos de perímetro en los que la autenticación o la protección XSRF forman parte del valor que tu servicio ofrece a tus clientes, tiene mucho más sentido "elegir lo aburrido" implementando middleware para la autenticación o la protección XSRF. De ese modo, aprovechas la experiencia del proveedor en esta área "exótica".

Advertencia

No hagas bricolaje con el middleware.

La cuestión es que, si optimizas las herramientas "menos malas" para el mayor número posible de tus problemas no diferenciadores, entonces será más fácil mantener y hacer funcionar el sistema y, por tanto, mantenerlo seguro. Si optimizas para conseguir la mejor herramienta para cada problema individual, o Regla de Cool, entonces los atacantes explotarán gustosamente tu sobrecarga cognitiva resultante y la asignación insuficiente de monedas de complejidad en cosas que ayuden al sistema a ser más resistente a los ataques. Por supuesto, seguir con algo aburrido que es ineficaz tampoco tiene sentido y también erosionará la resiliencia con el tiempo. Queremos aspirar al punto óptimo de aburrido y eficaz.

Normalización de las materias primas

La última práctica que trataremos en el ámbito de la funcionalidad crítica es la normalización de las "materias primas" que utilizamos cuando construimos y entregamos software, o cuando recomendamos prácticas a los equipos de ingeniería de software. Como comentamos en el último capítulo, podemos pensar en las "materias primas" de los sistemas de software como lenguajes, bibliotecas y herramientas (esto también se aplica al firmware y a otras materias primas que se utilizan en el hardware de los ordenadores, como las CPU y las GPU). Estas materias primas son elementos entretejidos en el software que deben ser resistentes y seguros para el funcionamiento del sistema.

Cuando construimos servicios de software, debemos ser decididos con los lenguajes, bibliotecas, marcos, servicios y fuentes de datos que elegimos, ya que el servicio heredará algunas de las propiedades de estas materias primas. Muchos de estos materiales pueden tener propiedades peligrosas, inadecuadas para construir un sistema según tus requisitos. O puede que el peligro sea esperado y, como no hay una alternativa mejor para tu dominio del problema, tendrás que aprender a vivir con él o pensar en otras formas de reducir los peligros mediante el diseño (de lo que hablaremos más en el Capítulo 7). En general, elegir más de una materia prima en cualquier categoría significa que obtienes los inconvenientes de ambas.

La Agencia de Seguridad Nacional (NSA) recomienda oficialmente utilizar lenguajes seguros en memoria siempre que sea posible, como C#, Go, Java, Ruby, Rust y Swift. El CTO de Microsoft Azure, Mark Russovovich, tuiteó de forma más contundente: "Hablando de lenguajes, es hora de dejar de iniciar cualquier proyecto nuevo en C/C++ y utilizar Rust para aquellos escenarios en los que se requiera un lenguaje que no sea CGC. Por el bien de la seguridad y la fiabilidad, la industria debería declarar esos lenguajes como obsoletos". Los problemas de seguridad de la memoria perjudican tanto al usuario como al fabricante de un producto o servicio, porque los datos que no deberían cambiar pueden convertirse mágicamente en un valor diferente. Como Matt Miller, ingeniero de software de seguridad asociado de Microsoft, presentó en 2019, el ~70% de las vulnerabilidades corregidas con un CVE asignado son vulnerabilidades de seguridad de memoria debidas a que los ingenieros de software introducen por error errores de seguridad de memoria en su código C y C++.

Cuando construyas o refactorices software, deberías elegir uno de las docenas de lenguajes populares que son seguros para la memoria por defecto. La inseguridad de la memoria es muy impopular en el diseño de lenguajes, lo cual es estupendo para nosotros, ya que tenemos una cornucopia de opciones seguras para la memoria de las que podemos escoger. Incluso podemos pensar en el código C como si fuera plomo; era muy conveniente para muchos casos de uso, pero nos está envenenando con el tiempo, sobre todo a medida que se acumula más .

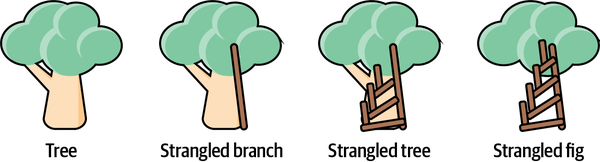

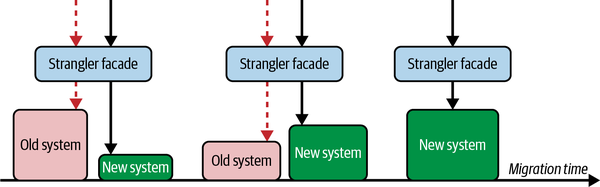

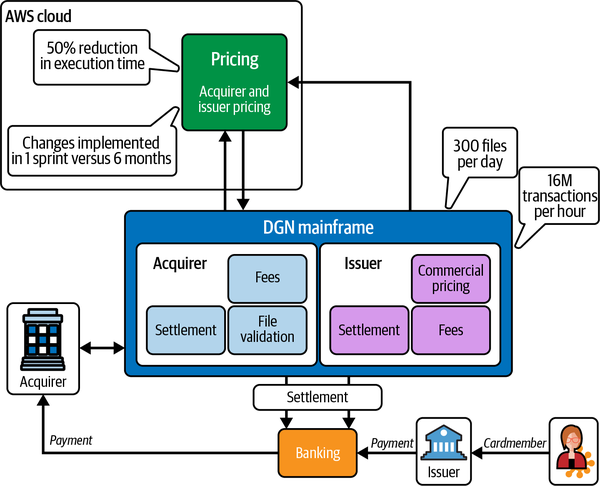

Idealmente, queremos adoptar materias primas menos peligrosas tan rápidamente como podamos, pero esta búsqueda a menudo no es trivial (como migrar de un lenguaje a otro). Las reescrituras completas pueden funcionar para sistemas más pequeños que tengan pruebas de integración, de extremo a extremo (E2E) y funcionales relativamente completas, pero esas condiciones no siempre serán ciertas. El patrón de la higa estranguladora, del que hablaremos al final del capítulo, es el enfoque más obvio para ayudarnos a cambiar iterativamente nuestra base de código.

Otra opción es elegir un lenguaje que se integre bien con C y hacer de tu aplicación una aplicación políglota, eligiendo cuidadosamente qué partes escribir en cada lenguaje. Este enfoque es más granular que el patrón de la higuera estranguladora y es similar al proyecto Oxidation, el enfoque de Mozilla para integrar código Rust en y alrededor de Firefox (que merece la pena explorar para obtener orientación sobre cómo migrar de C a Rust, en caso de que lo necesites). Algunos sistemas pueden incluso permanecer en este estado indefinidamente si hay ventajas en tener simultáneamente lenguajes de alto y bajo nivel en el mismo programa. Los juegos son un ejemplo común de esta dinámica: el código del motor necesita ser rápido para controlar la disposición de la memoria, pero el código del juego necesita ser rápido para iterar y el rendimiento importa mucho menos. Pero, en general, los servicios y programas políglotas son poco frecuentes, lo que hace que la normalización de algunos materiales sea algo más sencilla.

Los equipos de seguridad que deseen impulsar la adopción de la seguridad de la memoria deben asociarse con los humanos de tu organización que intentan impulsar las normas de ingeniería -ya sean prácticas, herramientas o marcos- y participar en ese proceso. En igualdad de condiciones, mantener la coherencia es significativamente mejor para la resiliencia. Los humanos que buscas están dentro de la organización de ingeniería, haciendo las conexiones y abogando por la adopción de estas normas.

Por otro lado, estos humanos tienen sus propios objetivos: construir de forma productiva más software y los sistemas que desea la empresa. Si tus peticiones son insensibles, te ignorarán. Así que no pidas cosas como desconectar los portátiles de los desarrolladores de Internet por motivos de seguridad. Sin embargo, hacer hincapié en las ventajas para la seguridad de refactorizar el código C en un lenguaje seguro para la memoria será más constructivo, ya que probablemente también encaje con sus objetivos, puesto que la productividad y los peligros operativos se cuelan notoriamente en C. La seguridad puede tener un terreno común sustancial con ese grupo de humanos sobre C, ya que ellos también quieren deshacerse de él (excepto por el humano ocasional que insiste en que todos deberíamos escribir en ensamblador y leer el manual de instrucciones de Intel).

Advertencia

Como subraya Mozilla, "cruzar la frontera C++/Rust puede ser difícil". Esto no debe subestimarse como inconveniente de este patrón. Dado que C define las API de la plataforma UNIX, la mayoría de los lenguajes tienen un sólido soporte de interfaz de funciones externas (FFI) para C. C++, sin embargo, carece de un soporte tan sustancial, ya que tiene muchas más rarezas de lenguaje con las que FFI tiene que lidiar y que potencialmente puede estropear.

El código que traspasa los límites de un lenguaje necesita atención adicional en todas las fases del desarrollo. Un enfoque emergente es atrapar todo el código C en una caja de arena WebAssembly con envoltorios FFI generados proporcionados automáticamente. Esto podría ser útil incluso para aplicaciones escritas totalmente en C, para poder atrapar las partes poco fiables y peligrosas en una caja de arena (como el análisis sintáctico de formatos ).

Las cachés son un ejemplo de materia prima peligrosa que a menudo se considera necesaria. Al almacenar datos en caché en nombre de un servicio, nuestro objetivo es reducir el volumen de tráfico hacia el servicio. Se considera un éxito tener un alto índice de aciertos de caché (CHR), y a menudo es más rentable escalar las cachés que escalar el servicio que hay detrás de ellas. Las cachés pueden ser la única forma de cumplir tus objetivos de rendimiento y coste, pero algunas de sus propiedades ponen en peligro la capacidad del sistema para mantener la resiliencia.

Existen dos peligros con respecto a la resiliencia. El primero es mundano: cada vez que cambian los datos, hay que invalidar las cachés o, de lo contrario, los datos parecerán obsoletos. La invalidación puede dar lugar a un comportamiento general del sistema peculiar o incorrecto -esas interacciones "desconcertantes" de la Zona de Peligro- si el sistema depende de datos coherentes. Si la coordinación no es correcta, los datos obsoletos pueden pudrirse en la caché indefinidamente.

El segundo peligro es un efecto sistémico en el que si las cachés fallan o se degradan alguna vez, ejercen presión sobre el servicio. Con CHRs altos, incluso un fallo parcial de la caché puede inundar un servicio backend. Si el servicio backend está caído, no puede llenar las entradas de la caché, y esto provoca que más tráfico bombardee el servicio backend. Los servicios sin caché se ralentizan, pero se recuperan con elegancia a medida que se añade más capacidad o disminuye el tráfico. Los servicios con caché se colapsan cuando se acercan a su capacidad y la recuperación suele requerir una capacidad adicional sustancial más allá del estado estacionario.

Sin embargo, incluso con estos peligros, las cachés tienen matices desde el punto de vista de la resiliencia. Benefician a la resiliencia porque pueden desacoplar las peticiones del origen (es decir, del servidor backend); el servicio soporta mejor las sorpresas, pero no necesariamente los fallos sostenidos. Mientras que los clientes están ahora menos estrechamente acoplados al comportamiento de nuestro origen, en su lugar pasan a estar estrechamente acoplados a la caché. Este acoplamiento estrecho garantiza una mayor eficacia y una reducción de costes, razón por la que se practica ampliamente el almacenamiento en caché. Pero, por las razones de resiliencia que acabamos de mencionar, pocas organizaciones "ruedan sus propias cachés". Por ejemplo, suelen subcontratar el almacenamiento en caché del tráfico web a un proveedor especializado, como una red de distribución de contenidos (CDN).

Consejo

Cada elección que hagas se resiste o capitula ante el acoplamiento estrecho. El colmo del acoplamiento débil es la plena intercambiabilidad de componentes y lenguajes en tus sistemas, pero los vendedores prefieren con mucho el bloqueo (es decir, el acoplamiento fuerte). Cuando tomes decisiones sobre tus materias primas, ten siempre en cuenta si te acercan o te alejan de la Zona de Peligro, introducida en el Capítulo 3.

Para recapitular, durante esta fase, podemos seguir cuatro prácticas para apoyar la funcionalidad crítica, el primer ingrediente de nuestra poción de resiliencia: el enfoque de la esclusa de aire, las revisiones meditadas del código, la elección de tecnología "aburrida" y la estandarización de las materias primas. Ahora, pasemos al segundo ingrediente: comprender los límites (umbrales) de seguridad del sistema .

Desarrollar y ofrecer para ampliar los límites de la seguridad

El segundo ingrediente de nuestra poción de resiliencia es comprender los límites de seguridad del sistema: los umbrales más allá de los cuales se desliza hacia el fracaso. Pero también podemos ayudar a ampliar esos límites durante esta fase, ampliando la ventana figurativa de tolerancia de nuestro sistema a las condiciones adversas. En esta sección se describe la gama de comportamientos que cabe esperar del sistema sociotécnico, en la que los humanos se encargan de curar el sistema a medida que se aleja del ideal diseñado (los modelos mentales construidos durante la fase de diseño y arquitectura). Hay cuatro prácticas clave que cubriremos y que apoyan los límites de seguridad: anticipar la escala, automatizar las comprobaciones de seguridad, estandarizar patrones y herramientas, y comprender las dependencias (incluida la priorización de las vulnerabilidades en ellas).

La buena noticia es que gran parte de conseguir una seguridad "correcta" es, en realidad, ingeniería sólida : cosas que quieres hacer para conseguir fiabilidad y resistencia a perturbaciones distintas de los ataques. En el mundo de la SCE, la seguridad de las aplicaciones se considera otra faceta de la calidad del software: dadas tus limitaciones, ¿cómo puedes escribir software de alta calidad que alcance tus objetivos? Las prácticas que exploraremos en esta sección generan un software de mayor calidad y resistencia.

En el último capítulo mencionamos que lo que queremos en nuestros sistemas es una adaptabilidad sostenida. Podemos cultivar la sostenibilidad durante esta fase como parte de la ampliación de nuestros límites de funcionamiento seguro también. La sostenibilidad y la resiliencia son conceptos interrelacionados en muchos ámbitos complejos. En la ciencia medioambiental, tanto la resiliencia como la sostenibilidad implican la preservación de la salud y el bienestar de la sociedad en presencia de cambios medioambientales.4 En ingeniería de software, solemos referirnos a la sostenibilidad como "mantenibilidad". No es menos cierto en nuestro trozo de vida que tanto la mantenibilidad como la resiliencia tienen que ver con la salud y el bienestar de los servicios de software en presencia de fuerzas desestabilizadoras, como los atacantes. Como exploraremos a lo largo de esta sección, apoyar las prácticas de ingeniería de software mantenibles -incluidos los flujos de trabajo repetibles- es vital para construir y entregar sistemas que puedan mantener la resiliencia frente a los ataques.

Los procesos por los que construyes y entregas deben ser claros, repetibles y mantenibles, tal y como describimos en el Capítulo 2 cuando presentamos RAVE. El objetivo es estandarizar la construcción y la entrega tanto como puedas para reducir las interacciones inesperadas. También significa que, en lugar de confiar en que todo esté perfecto antes de la implementación, puedes hacer frente a los errores porque solucionarlos es un proceso rápido, sencillo y repetible. Entretejer esta sostenibilidad en nuestras prácticas de construcción y entrega nos ayuda a ampliar nuestros límites de seguridad y a tener más gracia ante escenarios adversos.

Anticipar la escala y los SLO

La primera práctica de esta fase que puede ayudarnos a ampliar nuestros límites de seguridad es, sencillamente, anticipar la escala. Al construir sistemas de software resistentes, queremos considerar cómo pueden evolucionar las condiciones de funcionamiento y, por tanto, dónde están sus límites de funcionamiento seguro. A pesar de las mejores intenciones, los ingenieros de software a veces toman decisiones de arquitectura o implementación que inducen cuellos de botella de fiabilidad o escalabilidad.

Anticiparse a la escala es otra forma de desafiar esas suposiciones de "esto siempre será así" que describimos en el último capítulo, las que los atacantes explotan en sus operaciones. Piensa en un servicio de comercio electrónico. Podemos pensar: "En cada solicitud entrante, primero tenemos que correlacionar esa solicitud con la cesta de la compra anterior del usuario, lo que significa hacer una consulta a esta otra cosa". Hay una suposición de que "esto siempre será cierto" en este modelo mental: que la "otra cosa" siempre estará ahí. Si somos reflexivos, debemos cuestionarnos: "¿Y si esta otra cosa no está ahí? ¿Qué ocurriría entonces? Esto puede entonces refinar la forma en que construimos algo (y debemos documentar el por qué -lasuposición que hemos cuestionado-, como veremos más adelante en este capítulo). ¿Qué ocurre si la recuperación del carrito del usuario tarda en cargarse o no está disponible?

Cuestionar nuestras suposiciones de "esto siempre será así" también puede poner al descubierto posibles problemas de escalabilidad a niveles inferiores. Si decimos "siempre empezaremos con un gráfico de flujo de control, que es la salida de un análisis anterior", podemos cuestionarlo con una pregunta como "¿y si ese análisis es superlento o falla?". Invertir capital de esfuerzo en anticipar la escala puede garantizar que no constriñamos artificialmente los límites de seguridad de nuestro sistema, y que los umbrales potenciales se plieguen en nuestros modelos mentales del sistema.

Cuando construimos componentes que funcionarán como parte de sistemas grandes y distribuidos, parte de anticipar la escala consiste en prever lo que necesitarán los operadores durante los incidentes (es decir, qué inversiones de esfuerzo tienen que hacer). Si un ingeniero de guardia tarda horas en descubrir que el motivo de la repentina lentitud del servicio es una base de datos SQLite que nadie conocía, perjudicará a tus objetivos de rendimiento. También tenemos que prever cómo crecerá el negocio, como estimar el crecimiento del tráfico basándonos en hojas de ruta y planes de negocio, para prepararnos para ello. Cuando estimamos qué partes del sistema necesitaremos ampliar en el futuro y cuáles es improbable que necesiten ampliación, podemos ser ahorradores con nuestras inversiones de esfuerzo, al tiempo que garantizamos que el negocio pueda crecer sin impedimentos por las limitaciones del software.

Deberíamos ser cuidadosos a la hora de dar soporte a los patrones que discutimos en el último capítulo. Si diseñamos para la inmutabilidad y la efimeridad, esto significa que los ingenieros no pueden acceder por SSH al sistema para depurar o cambiar algo, y que la carga de trabajo se puede matar y reiniciar a voluntad. ¿Cómo cambia esto la forma en que construimos nuestro software? Una vez más, debemos captar estos porqués -que lo construimos así para apoyar la inmutabilidad y la efimeridad- para captar conocimientos (de los que hablaremos dentro de un rato). Hacerlo nos ayuda a ampliar nuestra ventana de tolerancia y solidifica nuestra comprensión de los umbrales del sistema más allá de los cuales estalla el fallo.

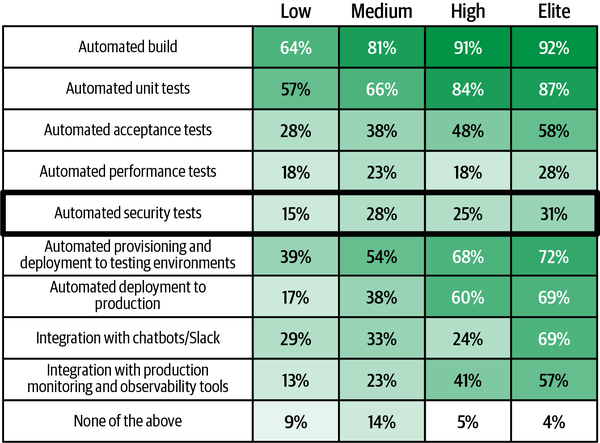

Automatizar las comprobaciones de seguridad mediante CI/CD

Una de las prácticas más valiosas para apoyar la ampliación de los límites de seguridad es automatizar las comprobaciones de seguridad aprovechando las tecnologías existentes para casos de uso de resiliencia. La práctica de la integración continua y la entrega continua5 (CI/CD) acelera el desarrollo y la entrega de funciones de software sin comprometer la fiabilidad ni la calidad.6 Una canalización CI/CD consiste en conjuntos de tareas (idealmente automatizadas) que entregan una nueva versión de software. Generalmente implica compilar la aplicación (lo que se conoce como "construcción"), probar el código, desplegar la aplicación en un repositorio o entorno de preparación, y entregar la aplicación a producción (lo que se conoce como "entrega"). Mediante la automatización, las canalizaciones de CI/CD garantizan que estas actividades se realicen a intervalos regulares con la mínima interferencia humana. Como resultado, CI/CD soporta las características de velocidad, fiabilidad y repetibilidad que necesitamos en nuestros sistemas para mantenerlos seguros y resistentes.

Consejo

- Integración continua (IC)

Los humanos integran y fusionan el trabajo de desarrollo (como el código) con frecuencia (como varias veces al día). Implica la construcción y comprobación automatizadas de software para conseguir ciclos de publicación más cortos y frecuentes, una mayor calidad del software y una productividad ampliada de los desarrolladores.

- Entrega continua (CD)

Los humanos introducen cambios en el software (como nuevas funciones, parches, ediciones de configuración, etc.) en la producción o para los usuarios finales. Implica la publicación e implementación automatizadas de software para conseguir actualizaciones de software más rápidas y seguras, que sean más repetibles y sostenibles.7

Deberíamos apreciar CI/CD no sólo como un mecanismo para evitar el trabajo de las implementaciones manuales, sino también como una herramienta para hacer que la entrega de software sea más repetible, predecible y coherente. Podemos aplicar invariantes, lo que nos permite conseguir las propiedades que queramos cada vez que creemos, implementemos y entreguemos software. Las empresas que pueden construir y entregar software más rápidamente también pueden mejorar las vulnerabilidades y los problemas de seguridad con mayor rapidez. Si puedes entregarlo cuando quieras, puedes estar seguro de que podrás enviar correcciones de seguridad cuando lo necesites. Para algunas empresas, eso puede ser cada hora y para otras, cada día. La cuestión es que tu organización puede entregar bajo demanda y, por tanto, responder a los eventos de seguridad bajo demanda.

Desde el punto de vista de la resiliencia, las Implementaciones manuales (y otras partes del flujo de trabajo de entrega) no sólo consumen un tiempo y un esfuerzo preciosos que sería mejor emplear en otra cosa, sino que también vinculan estrechamente al ser humano con el proceso, sin esperanza de linealidad. Los humanos son fabulosos adaptándose y respondiendo con variedad, y absolutamente inútiles haciendo lo mismo de la misma manera una y otra vez. El statu quo de seguridad y administración de sistemas de "ClickOps" es, desde este punto de vista, francamente peligroso. Aumenta el acoplamiento estrecho y la complejidad, sin las bendiciones de eficiencia que esperaríamos de este trato fáustico, equivalente a cambiar nuestra alma por una vida de tedio. La alternativa de las canalizaciones automatizadas CI/CD no sólo afloja el acoplamiento e introduce más linealidad, sino que también acelera la entrega del software, una de las situaciones en las que todos ganan que describimos en el último capítulo. Lo mismo ocurre con muchas formas de automatización del flujo de trabajo cuando el resultado son patrones estandarizados y repetibles.

En un ejemplo mucho más preocupante que el de las implementaciones manuales, las poblaciones indígenas locales de Noepe (Martha's Vineyard) se enfrentaron a los peligros del acoplamiento estrecho cuando el único servicio de transbordador que entregaba alimentos se vio interrumpido por la pandemia COVID-19.8 Si pensamos en nuestro oleoducto como un oleoducto de alimentos (como parte de la cadena de suministro de alimentos más amplia), entonces percibimos la necesidad conmovedora de fiabilidad y resistencia. No es diferente para nuestros conductos de construcción (que, afortunadamente, no ponen vidas en peligro).

Consejo

Cuando realizas experimentos de caos en tus sistemas, disponer de flujos de trabajo repetibles de creación e implementación te garantiza una forma sencilla de incorporar las conclusiones de esos experimentos y perfeccionar continuamente tu sistema. Contar con registros de creación e implementación versionados y auditables significa que puedes comprender más fácilmente por qué el sistema se comporta de forma diferente después de un cambio. El objetivo es que los ingenieros de software reciban información lo más inmediata posible, cuando el contexto aún está fresco. Quieren llegar a la meta de que su código funcione con éxito y fiabilidad en producción, así que aprovecha ese impulso emocional y ayúdales a conseguirlo.

Parches y actualizaciones de dependencias más rápidas

Un subconjunto de la automatización de las comprobaciones de seguridad para ampliar los límites de seguridad es la práctica de parchear y actualizar las dependencias más rápidamente. CI/CD puede ayudarnos con la aplicación de parches y, más en general, a mantener actualizadas las dependencias, lo que ayuda a evitar chocar con esos límites de seguridad. El parcheado es un problema que asola la ciberseguridad. El ejemplo más famoso es la brecha de Equifax de 2017, en la que una vulnerabilidad de Apache Struts no se parcheó hasta cuatro meses después de su revelación. Esto violó su mandato interno de parchear las vulnerabilidades en 48 horas, poniendo de relieve una vez más por qué las políticas estrictas son insuficientes para promover la resiliencia de los sistemas en el mundo real. Más recientemente, la vulnerabilidad Log4Shell 2021 en Log4j, de la que hablamos en el Capítulo 3, precipitó una ventisca de actividad tanto para encontrar sistemas vulnerables en toda la organización como para parchearlos sin romper nada.

En teoría, los desarrolladores quieren estar en la última versión de sus dependencias. Las últimas versiones tienen más funciones, incluyen correcciones de errores y a menudo tienen mejoras de rendimiento, escalabilidad y operatividad.9 Pero cuando los ingenieros están apegados a una versión más antigua, suele haber una razón. En la práctica, hay muchas razones por las que podrían no estarlo; algunas son muy razonables, otras no tanto.

Las presiones de producción son probablemente la razón más importante, porque la actualización es una tarea que no aporta ningún valor empresarial inmediato. Otra razón es que el versionado semántico (SemVer) es un ideal al que aspirar, pero es resbaladizo en la práctica. No está claro si el sistema se comportará correctamente cuando actualices a una nueva versión de la dependencia, a menos que dispongas de pruebas asombrosas que cubran completamente sus comportamientos, cosa que nadie tiene.

En el extremo menos razonable del espectro está la refactorización forzada, como cuando se escribe una dependencia o experimenta cambios sustanciales en la API. Esto es un síntoma de la predilección de los ingenieros por elegir tecnologías brillantes y nuevas frente a estables y "aburridas", es decir, elegir cosas que no son apropiadas para el trabajo real. Una última razón son las dependencias abandonadas. El creador de la dependencia ya no la mantiene y no se hizo un reemplazo directo, o el reemplazo directo es significativamente diferente.

Esta es precisamente la razón por la que la automatización -incluidas las canalizaciones CI/CD- puede ayudar, al eliminar el esfuerzo humano de mantener las dependencias actualizadas, liberando ese esfuerzo para actividades más valiosas, como la adaptabilidad. No queremos quemar su concentración con el tedio. Las canalizaciones CI/CD automatizadas permiten probar y enviar a producción actualizaciones y parches en cuestión de horas (¡o antes!), en lugar de los días, semanas o incluso meses que se tardaba tradicionalmente. Puede hacer que los ciclos de actualizaciones y parches sean un asunto automático y diario, eliminando el trabajo pesado para que otras prioridades puedan recibir atención.

Las pruebas de integración automatizadas significan que las actualizaciones y los parches se evaluarán para detectar posibles problemas de rendimiento o corrección antes de su implementación en producción, al igual que el resto del código. La preocupación de que las actualizaciones o los parches interrumpan los servicios de producción -lo que puede dar lugar a postergaciones o evaluaciones prolongadas que duran días o semanas- puede automatizarse, al menos en parte, invirtiendo en pruebas. Debemos esforzarnos en escribir pruebas que podamos automatizar, pero ahorraremos un esfuerzo considerable con el tiempo si evitamos las pruebas manuales.

Automatizar la fase de lanzamiento de la entrega de software también ofrece ventajas de seguridad. Empaquetar y desplegar automáticamente un componente de software acelera el tiempo de entrega, los parches y los cambios de seguridad, como ya hemos dicho. El control de versiones también es una ventaja para la seguridad, porque acelera la reversión y la recuperación en caso de que algo vaya mal. Hablaremos de las ventajas del aprovisionamiento automatizado de la infraestructura en la siguiente sección.

Ventajas de la entrega continua para la resistencia

La entrega continua es una práctica que sólo debes adoptar después de haber puesto en marcha otras prácticas descritas en esta sección e incluso en todo el capítulo. Si no tienes CI y pruebas automatizadas que detecten la mayoría de los fallos inducidos por los cambios, la DC será peligrosa y roerá tu capacidad de mantener la resiliencia. La DC requiere más rigor que la IC; se siente significativamente diferente. La IC te permite añadir automatización a tus procesos existentes y conseguir ventajas en el flujo de trabajo, pero en realidad no impone cambios en tu forma de implementar y poner en funcionamiento el software. La CD, sin embargo, exige que pongas orden en tu casa. Cualquier posible error que puedan cometer los desarrolladores como parte del desarrollo, después de suficiente tiempo, lo cometerán los desarrolladores. (La mayoría de las veces, por supuesto, todo lo que pueda salir bien, saldrá bien.) Todos los aspectos de las pruebas y la validación del software deben automatizarse para detectar esos errores antes de que se conviertan en fallos, y requiere más planificación en torno a la compatibilidad hacia atrás y hacia delante, los protocolos y los formatos de datos.

Teniendo en cuenta estas advertencias, ¿cómo puede ayudarnos la DC a mantener la resiliencia? Es imposible que las Implementaciones manuales sean repetibles. Es injusto esperar que un ingeniero humano ejecute implementaciones manuales sin fallos en todo momento, especialmente en condiciones ambiguas. Muchas cosas pueden salir mal incluso cuando las Implementaciones están automatizadas, por no hablar de cuando un humano realiza cada paso. La capacidad de recuperación -mediante la repetibilidad, la seguridad y la flexibilidad- está integrada en el objetivo de la DC: ofrecer cambios -ya sean nuevas funciones, configuraciones actualizadas, actualizaciones de versiones, correcciones de errores o experimentos- a los usuarios finales con una velocidad y seguridad sostenidas.10

Liberar con más frecuencia en realidad aumenta la estabilidad y la fiabilidad. Las objeciones habituales a la DC incluyen la idea de que la DC no funciona en entornos muy regulados, que no puede aplicarse a sistemas heredados y que implica enormes proezas de ingeniería para conseguirla. Gran parte de esto se basa en el mito, ahora totalmente refutado , de que moverse con rapidez aumenta intrínsecamente el "riesgo" (donde "riesgo" sigue siendo un concepto turbio).11

Aunque somos reacios a sugerir que las empresas de hiperescala se utilicen como ejemplo, merece la pena considerar a Amazon como un caso de estudio para los DC que trabajan en entornos regulados. Amazon gestiona miles de transacciones por minuto (hasta cientos de miles durante el Prime Day), por lo que está sujeta a PCI DSS (una norma de cumplimiento que cubre los datos de las tarjetas de crédito). Y, al ser una empresa que cotiza en bolsa, también se le aplica la Ley Sarbanes-Oxley que regula las prácticas contables. Pero, incluso en 2011, Amazon lanzaba cambios a producción cada 11,6 segundos de media, lo que sumaba 1.079 implementaciones por hora en los picos.12 Jez Humble, SRE y autor, escribe: "Esto es posible porque las prácticas que constituyen el núcleo de la entrega continua -gestión exhaustiva de la configuración, pruebas continuas e integración continua- permiten descubrir rápidamente defectos en el código, problemas de configuración en el entorno y problemas con el proceso de implementación".13 Cuando combinas la entrega continua con la experimentación del caos, obtienes ciclos de retroalimentación rápidos y procesables.

Esto puede sonar desalentador. Puede que tu cultura de seguridad tenga un nivel de teatralidad shakesperiana. Tu pila tecnológica se parece más a una pila de LEGOs que pisas dolorosamente. Pero puedes empezar poco a poco. El primer paso perfecto para trabajar hacia la CD es "PasteOps". Documenta el trabajo manual que supone desplegar cambios de seguridad o realizar tareas relacionadas con la seguridad como parte de la construcción, prueba e implementación. Una lista con viñetas en un recurso compartido puede bastar como MVP para la automatización, permitiendo una mejora iterativa que con el tiempo puede convertirse en scripts o herramientas reales. La SCE se basa en este tipo de mejoras iterativas. Piensa en la evolución de los sistemas naturales: los peces no desarrollaron de repente piernas, pulgares oponibles y pelo para convertirse en humanos. Cada generación ofrece mejores adaptaciones al entorno, del mismo modo que cada iteración de un proceso es una oportunidad de perfeccionamiento. Resiste la tentación de realizar un gran cambio radical, una reorganización o una migración. Sólo necesitas lo suficiente para poner en marcha el volante.

Normalización de patrones y herramientas

De forma similar a la práctica de estandarizar las materias primas de para apoyar la funcionalidad crítica, la estandarización de herramientas y patrones es una práctica que apoya la ampliación de los límites de seguridad y el mantenimiento de las condiciones operativas dentro de esos límites. La normalización puede resumirse como la garantía de que el trabajo producido es coherente con las directrices preestablecidas. La normalización ayuda a reducir la posibilidad de que los humanos cometan errores, al garantizar que una tarea se realiza siempre de la misma manera (para lo que los humanos no están diseñados). En el contexto de los patrones y herramientas estandarizados, nos referimos a la coherencia en lo que utilizan los desarrolladores para una interacción eficaz con el desarrollo continuo del software.

Se trata de un área en la que los equipos de seguridad y los de ingeniería de plataformas pueden colaborar para lograr el objetivo compartido de la normalización. De hecho, los equipos de ingeniería de plataformas podrían incluso realizar este trabajo por su cuenta, si así conviene a su contexto organizativo. Como seguimos diciendo, el manto de "defensor" le viene bien a cualquiera, independientemente de su título habitual, si está apoyando la resiliencia de los sistemas (hablaremos de esto con mucha más profundidad en el Capítulo 7).

Si no tienes un equipo de ingeniería de plataformas y todo lo que tienes son unos cuantos defensores ansiosos y un presupuesto escaso, aún puedes ayudar a estandarizar los patrones para los equipos y reducir la tentación de poner en marcha su propia cosa de una forma que atente contra la seguridad. La táctica más sencilla es dar prioridad a los patrones para las partes del sistema con mayores implicaciones para la seguridad, como la autenticación o el cifrado. Si a tu equipo le resultara difícil crear patrones, herramientas o marcos estandarizados, también puedes buscar bibliotecas estándar para recomendarlas y asegurarte de que esa lista esté disponible como documentación accesible. De ese modo, los equipos sabrán que existe una lista de bibliotecas bien validadas que deben consultar y elegir cuando necesiten implementar una funcionalidad específica. Cualquier otra cosa que quieran utilizar fuera de esas bibliotecas puede merecer una discusión, pero por lo demás pueden avanzar en su trabajo sin interrumpir el trabajo del equipo de seguridad o de ingeniería de la plataforma.

Lo consigas como lo consigas, construir una "Carretera Pavimentada" para otros equipos es una de las actividades más valiosas de un programa de seguridad. Las carreteras asfaltadas son soluciones bien integradas y respaldadas a problemas comunes que permiten a los humanos centrarse en su creación de valor único (como crear una lógica empresarial diferenciada para una aplicación).14 Aunque la mayoría de las veces pensamos en las carreteras asfaltadas en el contexto de las actividades de ingeniería de productos, las carreteras asfaltadas son absolutamente aplicables en otras partes de la organización, como la seguridad. Imagina un programa de seguridad que encuentre formas de acelerar el trabajo. Facilitar a un vendedor la adopción de una nueva aplicación SaaS que le ayude a cerrar más tratos es una carretera asfaltada. Facilitar a los usuarios la auditoría de la seguridad de su cuenta, en lugar de enterrarla en menús anidados, también es un camino pavimentado. Hablaremos más sobre la habilitación de carreteras pavimentadas como parte de un programa de resiliencia en el Capítulo 7.

Carreteras asfaltadas en acción: Ejemplos de la naturaleza

Un buen ejemplo de un camino allanado -estandarizar unos cuantos patrones para los equipos en un marco de trabajo de valor incalculable-es el marco de trabajo Wall-E de Netflix. Como reconocerá cualquiera que haya tenido que hacer malabarismos para decidir sobre la autenticación, el registro, la observabilidad y otros patrones mientras intentaba crear una aplicación con un presupuesto reducido, que te leguen este tipo de marco suena como el paraíso. Dando un paso atrás, es un ejemplo perfecto de cómo podemos ser pioneros para que las soluciones de resiliencia (y seguridad) satisfagan las presiones de la producción: el "santo grial" en SCE. Como muchos de los que trabajan en tecnología, nos acobardamos ante la palabra sinergias, pero en este caso son reales -como en muchos caminos asfaltados- y puede que te congracie con tu director financiero para que te apoye en la transformación del SCE.

Partiendo de la base de un curioso programa de seguridad, Netflix empezó con la observación de que los equipos de ingeniería de software tenían que tener en cuenta demasiados aspectos de seguridad al crear y entregar software: autenticación, registro, certificados TLS y más. Tenían extensas listas de comprobación de seguridad para los desarrolladores que creaban esfuerzo manual y eran confusas de realizar (como Netflix declaró: "Había diagramas de flujo dentro de las listas de comprobación. Ouch"). El status quo también creaba más trabajo para su equipo de ingeniería de seguridad, que de todos modos tenía que guiar a los desarrolladores a través de la lista de comprobación y validar sus elecciones manualmente.

Por eso, el equipo de seguridad de aplicaciones (appsec) de Netflix se preguntó cómo construir un camino pavimentado para el proceso, produciéndolo. Su equipo piensa en el camino pavimentado como una forma de esculpir preguntas en proposiciones booleanas. En su ejemplo, en lugar de decir: "Dime cómo hace tu aplicación esto tan importante para la seguridad", comprueban que el equipo está utilizando el camino pavimentado pertinente para gestionar el tema de la seguridad.

El camino pavimentado que construyó Netflix, llamado Wall-E, estableció un patrón de adición de requisitos de seguridad como filtros que sustituyeron a las listas de comprobación existentes que requerían cortafuegos de aplicaciones web (WAF), prevención de DDoS, validación de encabezados de seguridad y registro duradero. En sus propias palabras: "Al final, pudimos añadir tantas ventajas de seguridad a Wall-E que la mayor parte de la lista de comprobación para las aplicaciones de Studio se redujo a un solo elemento: ¿Usarás Wall-E?"

También pensaron mucho en reduciendo la fricción de la adopción (en gran parte porque la adopción era una métrica de éxito clave para ellos; otros equipos de seguridad, tomen nota). Al comprender los patrones de flujo de trabajo existentes, pidieron a los equipos de ingeniería de productos que se integraran con Wall-E creando un archivo YAML controlado por versiones, lo que, aparte de facilitar el empaquetado de los datos de configuración, también "recogió la intención de los desarrolladores". Puesto que disponían de una "definición concisa y estandarizada de la aplicación que pretendían exponer", Wall-E podía automatizar proactivamente gran parte del arduo trabajo que los desarrolladores no querían hacer tras sólo unos minutos de configuración. Los resultados benefician tanto a la eficiencia como a la resiliencia, exactamente lo que buscamos para satisfacer la sed de nuestras organizaciones de hacer más rápidamente, y nuestra búsqueda de resiliencia: "Para una aplicación típica de carretera asfaltada sin complicaciones de seguridad inusuales, un equipo podría pasar de git init a una aplicación lista para producción, totalmente autenticada y accesible por Internet en algo menos de 10 minutos". A los desarrolladores del producto no les importaba necesariamente la seguridad, pero la adoptaron con entusiasmo cuando se dieron cuenta de que este patrón estandarizado les ayudaba a enviar el código a los usuarios con mayor rapidez y a iterar más rápidamente, y la iteración es una forma clave de fomentar la flexibilidad durante la construcción y la entrega, como veremos al final del capítulo.

Análisis de dependencia y priorización de vulnerabilidades

La última práctica que podemos adoptar para ampliar y preservar nuestros límites de seguridad es el análisis de dependencias y, en particular, la priorización prudente de las vulnerabilidades. El análisis de dependencias, especialmente en el contexto de la detección de errores (incluidas las vulnerabilidades de seguridad), nos ayuda a comprender los fallos de nuestras herramientas para que podamos corregirlos o mitigarlos , o incluso considerar la posibilidad de utilizar herramientas mejores. Podemos tratar esta práctica como una protección contra posibles factores de estrés y sorpresas, lo que nos permite invertir nuestro capital de esfuerzo en otra cosa. Sin embargo, el sector de la seguridad no ha facilitado la comprensión de cuándo una vulnerabilidad es importante, así que empezaremos revelando heurísticas para saber cuándo debemos invertir esfuerzo en solucionarlas.

Priorizar las vulnerabilidades

¿Cuándo debes preocuparte por una vulnerabilidad? Supongamos que una nueva vulnerabilidad se difunde en las redes sociales. ¿Significa esto que debes parar todo para implementar una solución o un parche? ¿O la fatiga de la alarma enervará tu motivación? Que debas preocuparte por una vulnerabilidad depende de dos factores principales:

¿Es fácil automatizar y escalar el ataque?

¿A cuántos pasos está el ataque del resultado del objetivo del atacante?

El primer factor -la facilidad para automatizar y escalar el ataque (es decir, el aprovechamiento de la vulnerabilidad)- se describe históricamente en con el término "wormable".15 ¿Puede un atacante aprovechar esta vulnerabilidad a escala? Un ataque que no requiera interacción alguna por parte del atacante sería fácil de automatizar y escalar. La minería de criptomonedas suele estar en esta categoría. El atacante puede crear un servicio automatizado que escanee una herramienta como Shodan en busca de instancias vulnerables de aplicaciones que requieran un amplio cómputo, como Kibana o una herramienta CI. A continuación, el atacante ejecuta un script de ataque automatizado contra la instancia, y luego descarga y ejecuta automáticamente la carga útil de minería criptográfica, si tiene éxito. El atacante puede ser notificado si algo va mal (igual que tu típico equipo de Operaciones), pero a menudo puede dejar que este tipo de herramienta funcione completamente sola mientras se centra en otra actividad delictiva. Su estrategia consiste en conseguir tantas pistas como puedan para maximizar el potencial de monedas minadas durante cualquier periodo de tiempo.