Capítulo 4. Patrones de concurrencia en Go

Este trabajo se ha traducido utilizando IA. Agradecemos tus opiniones y comentarios: translation-feedback@oreilly.com

Hemos explorado los fundamentos de las primitivas de concurrencia de Go y discutido cómo utilizarlas adecuadamente. En este capítulo, profundizaremos en cómo componer estas primitivas en patrones que te ayudarán a mantener tu sistema escalable y mantenible.

Sin embargo, antes de empezar, tenemos que tocar el formato de algunos de los patrones contenidos en este capítulo. En muchos de los ejemplos, utilizaremos canales que pasan interfaces vacías (interface{}). El uso de interfaces vacías en Go es controvertido; sin embargo, lo he hecho por un par de razones. La primera es que facilita la redacción de ejemplos concisos en el resto del libro. La segunda es que en algunos casos creo que esto es más representativo de lo que el patrón intenta conseguir. Trataremos este punto más directamente en la sección "Tuberías".

Si esto te parece demasiado polémico, recuerda que siempre puedes crear generadores Go para este código, y generar los patrones para utilizar el tipo que te interese.

Dicho esto, ¡vamos a sumergirnos y a conocer algunos patrones de concurrencia en Go!

Encierro

Cuando se trabaja con código concurrente, hay algunas opciones diferentes para un funcionamiento seguro. Hemos repasado dos de ellas:

-

Primitivas de sincronización para compartir memoria (por ejemplo,

sync.Mutex) -

Sincronización mediante comunicación (por ejemplo, canales)

Sin embargo, hay un par de opciones más que son implícitamente seguras dentro de varios procesos concurrentes:

-

Datos inmutables

-

Datos protegidos por confinamiento

En cierto sentido, los datos inmutables son ideales porque son implícitamente seguros para la concurrencia. Cada proceso concurrente puede operar sobre los mismos datos, pero no puede modificarlos. Si quiere crear nuevos datos, debe crear una nueva copia de los datos con las modificaciones deseadas. Esto no sólo permite aligerar la carga cognitiva del desarrollador, sino que también puede dar lugar a programas más rápidos si conduce a secciones críticas más pequeñas (o las elimina por completo). En Go, puedes conseguirlo escribiendo código que utilice copias de valores en lugar de punteros a valores en memoria. Algunos lenguajes admiten la utilización de punteros con valores explícitamente inmutables; sin embargo, Go no se encuentra entre ellos.

El confinamiento también puede permitir una carga cognitiva más ligera para el desarrollador y secciones críticas más pequeñas. Las técnicas para confinar valores concurrentes son un poco más complicadas que simplemente pasar copias de valores, así que en este capítulo exploraremos estas técnicas de confinamiento en profundidad.

El confinamiento es la sencilla pero poderosa idea de garantizar que la información sólo esté disponible desde un proceso concurrente. Cuando se consigue esto, un programa concurrente es implícitamente seguro y no necesita sincronización. Hay dos tipos de confinamiento posibles: ad hoc y léxico.

El confinamiento ad hoc es cuando consigues el confinamiento mediante una convención, ya sea establecida por la comunidad de lenguajes, el grupo en el que trabajas o la base de código en la que trabajas. En mi opinión, atenerse a una convención es difícil de conseguir en proyectos de cualquier tamaño, a menos que dispongas de herramientas para realizar un análisis estático de tu código cada vez que alguien confirma algo de código. He aquí un ejemplo de confinamiento ad hoc que demuestra por qué:

data:=make([]int,4)loopData:=func(handleDatachan<-int){deferclose(handleData)fori:=rangedata{handleData<-data[i]}}handleData:=make(chanint)goloopData(handleData)fornum:=rangehandleData{fmt.Println(num)}

Podemos ver que la porción de enteros data está disponible tanto desde la función loopData como desde el bucle sobre el canal handleData; sin embargo, por convención, sólo accedemos a ella desde la función loopData. Pero como el código lo tocan muchas personas, y los plazos se acercan, podrían cometerse errores, y el confinamiento podría romperse y causar problemas. Como ya he dicho, una herramienta de análisis estático podría detectar este tipo de problemas, pero el análisis estático en una base de código Go sugiere un nivel de madurez que no muchos equipos alcanzan. Por eso prefiero el confinamiento léxico: utiliza el compilador para imponer el confinamiento.

El confinamiento léxico consiste en utilizar el ámbito léxico para exponer sólo los datos y primitivas de concurrencia correctos para que los utilicen varios procesos concurrentes. Hace que sea imposible hacer lo incorrecto. En realidad, ya hemos tratado este tema en el Capítulo 3. Recuerda la sección sobre canales, en la que se habla de exponer sólo los aspectos de lectura o escritura de un canal a los procesos concurrentes que los necesitan. Volvamos a ver ese ejemplo:

chanOwner:=func()<-chanint{results:=make(chanint,5)gofunc(){deferclose(results)fori:=0;i<=5;i++{results<-i}}()returnresults}consumer:=func(results<-chanint){forresult:=rangeresults{fmt.Printf("Received: %d\n",result)}fmt.Println("Done receiving!")}results:=chanOwner()consumer(results)

Aquí instanciamos el canal dentro del ámbito léxico de la función

chanOwner. Esto limita el alcance del aspecto de escritura del canalresultsal cierre definido debajo de él. En otras palabras, limita el aspecto de escritura de este canal para evitar que otras goroutines escriban en él.

Aquí recibimos el aspecto de lectura del canal y podemos pasarlo al consumidor, que no puede hacer otra cosa que leer de él. Una vez más, esto confina la goroutina principal a una vista de sólo lectura del canal.

Aquí recibimos una copia de sólo lectura de un canal

int. Al declarar que el único uso que requerimos es el acceso de lectura, limitamos el uso del canal dentro de la funciónconsumea sólo lecturas.

Configurado de este modo, es imposible utilizar los canales en este pequeño ejemplo. Es una buena introducción al confinamiento, pero probablemente no sea un ejemplo muy interesante, ya que los canales son seguros para la concurrencia. Veamos un ejemplo de confinamiento que utiliza una estructura de datos que no es segura para la concurrencia, una instancia de bytes.Buffer:

printData:=func(wg*sync.WaitGroup,data[]byte){deferwg.Done()varbuffbytes.Bufferfor_,b:=rangedata{fmt.Fprintf(&buff,"%c",b)}fmt.Println(buff.String())}varwgsync.WaitGroupwg.Add(2)data:=[]byte("golang")goprintData(&wg,data[:3])goprintData(&wg,data[3:])wg.Wait()

Aquí pasamos un trozo que contiene los tres primeros bytes de la estructura

data.

Aquí pasamos un trozo que contiene los tres últimos bytes de la estructura

data.

En este ejemplo, puedes ver que como printData no se cierra alrededor de la porción data, no puede acceder a ella, y necesita tomar una porción de byte para operar sobre ella. Pasamos diferentes subconjuntos de la porción, limitando así las goroutinas que iniciamos sólo a la parte de la porción que pasamos. Gracias al ámbito léxico, hemos hecho imposible1 hacer lo incorrecto, por lo que no necesitamos sincronizar el acceso a la memoria ni compartir datos mediante comunicación.

Entonces, ¿qué sentido tiene? ¿Por qué perseguir el confinamiento si tenemos a nuestra disposición la sincronización? La respuesta es la mejora del rendimiento y la reducción de la carga cognitiva de los desarrolladores. La sincronización tiene un coste, y si puedes evitarla no tendrás secciones críticas, y por tanto no tendrás que pagar el coste de sincronizarlas. También eludes toda una clase de problemas posibles con la sincronización; los desarrolladores simplemente no tienen que preocuparse por estos problemas. El código concurrente que utiliza el confinamiento léxico también tiene la ventaja de que suele ser más sencillo de entender que el código concurrente sin variables confinadas léxicamente. Esto se debe a que dentro del contexto de tu ámbito léxico puedes escribir código síncrono.

Dicho esto, puede resultar difícil establecer el confinamiento, por lo que a veces tenemos que recurrir a nuestras maravillosas primitivas de concurrencia Go.

El bucle for-select

Algo que verás una y otra vez en los programas Go es el bucle for-select. No es más que algo así

for{// Either loop infinitely or range over somethingselect{// Do some work with channels}}

Hay un par de escenarios diferentes en los que verás aparecer este patrón.

- Enviar variables de iteración por un canal

-

A menudo querrás convertir algo sobre lo que se puede iterar en valores de un canal. Esto no es nada del otro mundo, y suele tener un aspecto parecido a éste:

for_,s:=range[]string{"a","b","c"}{select{case<-done:returncasestringStream<-s:}} - En bucle infinito esperando ser detenido

-

Es muy común crear goroutines que hagan un bucle infinito hasta que se detengan. Hay un par de variantes de ésta. La que elijas es puramente una preferencia estilística.

La primera variante mantiene la declaración

selectlo más breve posible:for{select{case<-done:returndefault:}// Do non-preemptable work}Si el canal

doneno está cerrado, saldremos de la declaraciónselecty continuaremos con el resto del cuerpo de nuestro buclefor.La segunda variante incluye el trabajo en una cláusula

defaultde la declaraciónselect:for{select{case<-done:returndefault:// Do non-preemptable work}}Cuando entremos en la declaración

select, si el canaldoneno se ha cerrado, ejecutaremos en su lugar la cláusuladefault.Este patrón no tiene nada más, pero aparece por todas partes, por lo que merece la pena mencionarlo.

Prevenir las fugas de goroutine

Como vimos en la sección "Goroutines", sabemos que las goroutines son baratas y fáciles de crear; es una de las cosas que hacen de Go un lenguaje tan productivo. El tiempo de ejecución se encarga de multiplexar las goroutinas en cualquier número de hilos del sistema operativo, de modo que no solemos tener que preocuparnos por ese nivel de abstracción. Pero cuestan recursos, y el tiempo de ejecución no recoge la basura de las goroutines, así que, por pequeña que sea su huella de memoria, no queremos dejarlas tiradas en nuestro proceso. Entonces, ¿cómo nos aseguramos de que se limpian?

Empecemos por el principio y pensemos en esto paso a paso: ¿por qué existiría una gorutina? En el Capítulo 2, establecimos que las gorutinas representan unidades de trabajo que pueden o no ejecutarse en paralelo entre sí. La gorutina tiene varios caminos hacia la terminación:

-

Cuando haya terminado su trabajo.

-

Cuando no puede continuar su trabajo debido a un error irrecuperable.

-

Cuando se le diga que deje de funcionar.

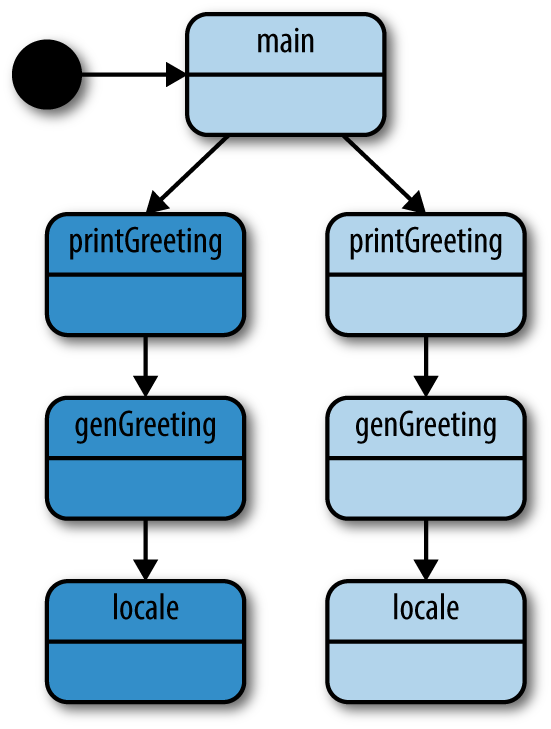

Obtenemos los dos primeros caminos gratis -estos caminos son tu algoritmo-, pero ¿qué pasa con la cancelación del trabajo? Esto resulta ser lo más importante debido al efecto de red: si has iniciado una gorutina, lo más probable es que esté cooperando con otras gorutinas de alguna forma organizada. Podríamos incluso representar esta interconexión como un grafo: si una goroutina hija debe o no seguir ejecutándose podría basarse en el conocimiento del estado de muchas otras goroutinas. La goroutina padre (a menudo la goroutina principal), con este conocimiento contextual completo, debería ser capaz de indicar a sus goroutinas hijas que terminen. Seguiremos estudiando la interdependencia a gran escala de las goroutinas en el próximo capítulo, pero por ahora vamos a considerar cómo asegurar que una sola goroutina hija tenga garantizada la limpieza. Empecemos con un ejemplo sencillo de fuga de una gorutina:

doWork:=func(strings<-chanstring)<-chaninterface{}{completed:=make(chaninterface{})gofunc(){deferfmt.Println("doWork exited.")deferclose(completed)fors:=rangestrings{// Do something interestingfmt.Println(s)}}()returncompleted}doWork(nil)// Perhaps more work is done herefmt.Println("Done.")

Aquí vemos que la goroutina principal pasa un canal nulo a doWork. Por lo tanto, el canal strings en realidad nunca recibirá ninguna cadena escrita en él, y la gorutina que contiene doWork permanecerá en memoria durante toda la vida de este proceso (incluso nos bloquearíamos si uniéramos la gorutina dentro de doWork y la gorutina principal).

En este ejemplo, la vida del proceso es muy corta, pero en un programa real, las goroutinas podrían iniciarse fácilmente al principio de un programa de larga vida. En el peor de los casos, la goroutina principal podría seguir haciendo girar goroutinas a lo largo de su vida, provocando una fluencia en la utilización de la memoria.

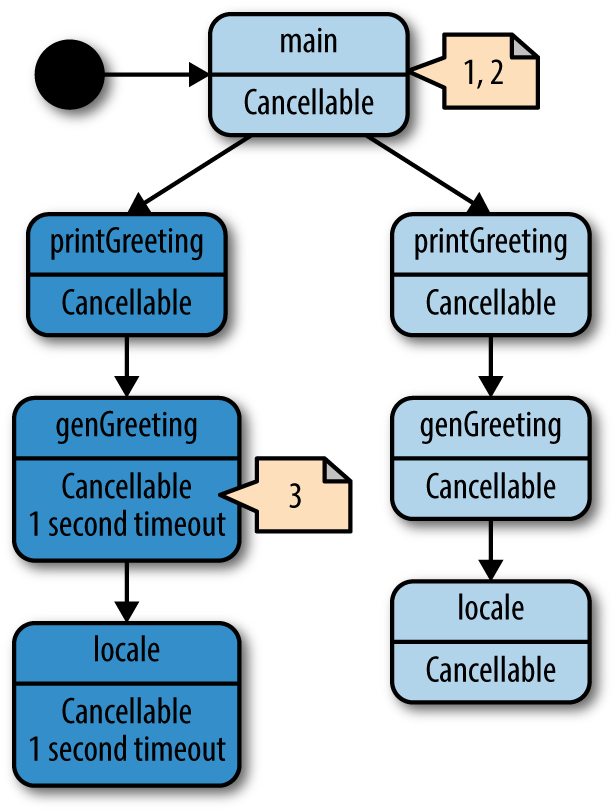

La forma de mitigarlo con éxito es establecer una señal entre la gorutina padre y sus hijas que permita a la padre señalar la cancelación a sus hijas. Por convención, esta señal suele ser un canal de sólo lectura llamado done. La goroutina padre pasa este canal a la goroutina hija y luego cierra el canal cuando quiere cancelar la goroutina hija. He aquí un ejemplo:

doWork:=func(done<-chaninterface{},strings<-chanstring,)<-chaninterface{}{terminated:=make(chaninterface{})gofunc(){deferfmt.Println("doWork exited.")deferclose(terminated)for{select{cases:=<-strings:// Do something interestingfmt.Println(s)case<-done:return}}}()returnterminated}done:=make(chaninterface{})terminated:=doWork(done,nil)gofunc(){// Cancel the operation after 1 second.time.Sleep(1*time.Second)fmt.Println("Canceling doWork goroutine...")close(done)}()<-terminatedfmt.Println("Done.")

Aquí pasamos el canal

donea la funcióndoWork. Por convención, este canal es el primer parámetro.

En esta línea vemos el omnipresente patrón for-select en uso. Una de nuestras sentencias case comprueba si nuestro canal

doneha recibido la señal. Si es así, volvemos de la goroutine.

Aquí creamos otra goroutina que cancelará la goroutina generada en

doWorksi pasa más de un segundo.

Aquí es donde unimos la goroutine generada desde

doWorkcon la goroutine principal.

Y la salida resultante es

Canceling doWork goroutine... doWork exited. Done.

Puedes ver que, a pesar de pasar nil para nuestro canal strings, nuestra goroutina sigue saliendo con éxito. A diferencia del ejemplo anterior, en este ejemplo sí unimos las dos goroutinas, y sin embargo no se produce un bloqueo. Esto se debe a que antes de unir las dos goroutinas, creamos una tercera goroutina para cancelar la goroutina dentro de doWork después de un segundo. ¡Hemos eliminado con éxito la fuga de nuestra gorutina!

El ejemplo anterior maneja bien el caso de las goroutinas que reciben en un canal, pero ¿qué ocurre si nos enfrentamos a la situación inversa: una goroutina bloqueada al intentar escribir un valor en un canal? He aquí un ejemplo rápido para demostrar el problema:

newRandStream:=func()<-chanint{randStream:=make(chanint)gofunc(){deferfmt.Println("newRandStream closure exited.")deferclose(randStream)for{randStream<-rand.Int()}}()returnrandStream}randStream:=newRandStream()fmt.Println("3 random ints:")fori:=1;i<=3;i++{fmt.Printf("%d: %d\n",i,<-randStream)}

La ejecución de este código produce:

3 random ints: 1: 5577006791947779410 2: 8674665223082153551 3: 6129484611666145821

Puedes ver en la salida que la sentencia fmt.Println diferida nunca se ejecuta. Después de la tercera iteración de nuestro bucle, nuestra goroutina se bloquea intentando enviar el siguiente entero aleatorio a un canal del que ya no se está leyendo. No tenemos forma de decirle al productor que puede parar. La solución, igual que para el caso de la recepción, es proporcionar a la goroutina productora un canal que le informe de que debe salir:

newRandStream:=func(done<-chaninterface{})<-chanint{randStream:=make(chanint)gofunc(){deferfmt.Println("newRandStream closure exited.")deferclose(randStream)for{select{caserandStream<-rand.Int():case<-done:return}}}()returnrandStream}done:=make(chaninterface{})randStream:=newRandStream(done)fmt.Println("3 random ints:")fori:=1;i<=3;i++{fmt.Printf("%d: %d\n",i,<-randStream)}close(done)// Simulate ongoing worktime.Sleep(1*time.Second)

Este código produce:

3 random ints: 1: 5577006791947779410 2: 8674665223082153551 3: 6129484611666145821 newRandStream closure exited.

Ahora vemos que la goroutina se limpia correctamente.

Ahora que sabemos cómo garantizar que las goroutinas no tengan fugas, podemos estipular una convención: Si una goroutina es responsable de crear una goroutina, también es responsable de asegurarse de que puede detener la goroutina.

Esta convención te ayudará a garantizar que tus programas sean componibles y escalables a medida que crecen. Volveremos sobre esta técnica y gobernaremos más en las secciones "Tuberías" y "El paquete contextual". La forma de garantizar que las goroutines puedan detenerse puede variar según el tipo y la finalidad de la goroutine, pero todas parten de la base de pasar un canal done.

El canal or

A veces puede que quieras combinar uno o más canales done en un único canal done que se cierre si se cierra cualquiera de los canales que lo componen. Es perfectamente aceptable, aunque verboso, escribir una sentencia select que realice este acoplamiento; sin embargo, a veces no puedes saber el número de canales done con los que estás trabajando en tiempo de ejecución. En este caso, o si simplemente prefieres una sola línea, puedes combinar estos canales utilizando el patrón o-canal.

Este patrón crea un canal compuesto done mediante recursividad y goroutines. Echemos un vistazo:

varorfunc(channels...<-chaninterface{})<-chaninterface{}or=func(channels...<-chaninterface{})<-chaninterface{}{switchlen(channels){case0:returnnilcase1:returnchannels[0]}orDone:=make(chaninterface{})gofunc(){deferclose(orDone)switchlen(channels){case2:select{case<-channels[0]:case<-channels[1]:}default:select{case<-channels[0]:case<-channels[1]:case<-channels[2]:case<-or(append(channels[3:],orDone)...):}}}()returnorDone}

Aquí tenemos nuestra función,

or, que toma una porción variádica de canales y devuelve un único canal.

Como se trata de una función recursiva, debemos establecer criterios de terminación. El primero es que si la rebanada variádica está vacía, simplemente devolvemos un canal nulo. Esto es coherente con la idea de no pasar canales; no esperaríamos que un canal compuesto hiciera nada.

Nuestro segundo criterio de terminación establece que si nuestra rebanada variádica sólo contiene un elemento, sólo devolvemos ese elemento.

Aquí está el cuerpo principal de la función, y donde se produce la recursividad. Creamos una goroutine para poder esperar mensajes en nuestros canales sin bloquearnos.

Debido a cómo estamos recursando, cada llamada recursiva a

ortendrá al menos dos canales. Como optimización para mantener limitado el número de goroutines, colocamos aquí un caso especial para las llamadas aorcon sólo dos canales.

Aquí creamos recursivamente un canal or a partir de todos los canales de nuestra rebanada después del tercer índice, y luego seleccionamos a partir de él. Esta relación de recurrencia desestructurará el resto de la rebanada en canales or para formar un árbol del que volverá la primera señal. También pasamos el canal

orDonepara que cuando salgan las goroutines del árbol superior, salgan también las goroutines del árbol inferior.

Se trata de una función bastante concisa que te permite combinar cualquier número de canales en un único canal que se cerrará en cuanto se cierre o se escriba en cualquiera de los canales que lo componen. Veamos cómo podemos utilizar esta función. He aquí un breve ejemplo que toma canales que se cierran tras una duración determinada, y utiliza la función or para combinarlos en un único canal que se cierra:

sig:=func(aftertime.Duration)<-chaninterface{}{c:=make(chaninterface{})gofunc(){deferclose(c)time.Sleep(after)}()returnc}start:=time.Now()<-or(sig(2*time.Hour),sig(5*time.Minute),sig(1*time.Second),sig(1*time.Hour),sig(1*time.Minute),)fmt.Printf("done after %v",time.Since(start))

Esta función simplemente crea un canal que se cerrará cuando transcurra el tiempo especificado en

after.

Aquí llevamos la cuenta de aproximadamente cuándo empieza a bloquearse el canal de la función

or.

Y aquí imprimimos el tiempo que tardó en producirse la lectura.

Si ejecutas este programa obtendrás

done after 1.000216772s

Observa que, a pesar de colocar varios canales en nuestra llamada a or que tardan varios tiempos en cerrarse, nuestro canal que se cierra al cabo de un segundo hace que se cierre todo el canal creado por la llamada a or. Esto se debe a que -a pesar de su lugar en el árbol que construye la función or - siempre se cerrará primero y, por lo tanto, los canales que dependen de su cierre también se cerrarán.

Conseguimos esta tersura a costa de goroutines adicionales-f(x)=⌊x/2⌋ donde x es el número de goroutines-pero recuerda que uno de los puntos fuertes de Go es la capacidad de crear, programar y ejecutar goroutines rápidamente, y el lenguaje fomenta activamente el uso de goroutines para modelar problemas correctamente. Preocuparse por el número de goroutines creadas aquí es probablemente una optimización prematura. Además, si en tiempo de compilación no sabes con cuántos canales done estás trabajando, no hay otra forma de combinar canales done.

Este patrón es útil para emplearlo en la intersección de módulos de tu sistema. En estas intersecciones, sueles tener múltiples condiciones para cancelar árboles de goroutines a través de tu pila de llamadas. Utilizando la función or, puedes simplemente combinarlas y pasarlas por la pila. Veremos otra forma de hacerlo en "El paquete de contexto" que también es muy agradable, y quizás un poco más descriptiva.

También veremos cómo podemos utilizar una variación de este patrón para formar un patrón más complicado en "Solicitudes replicadas".

Tratamiento de errores

En los programas concurrentes, la gestión de errores puede ser difícil de hacer bien. A veces, pasamos tanto tiempo pensando en cómo nuestros distintos procesos compartirán información y se coordinarán, que nos olvidamos de considerar cómo manejarán con elegancia los estados de error. Cuando Go rechazó el popular modelo de excepción de errores, hizo una declaración de que la gestión de errores era importante, y que al desarrollar nuestros programas, deberíamos prestar a nuestras rutas de error la misma atención que prestamos a nuestros algoritmos. Con ese espíritu, echemos un vistazo a cómo lo hacemos cuando trabajamos con múltiples procesos concurrentes.

La pregunta más fundamental cuando se piensa en la gestión de errores es: "¿Quién debe ser responsable de gestionar el error?". En algún momento, el programa tiene que dejar de transportar el error por la pila y hacer realmente algo con él. ¿Quién es responsable de ello?

Con procesos concurrentes, esta cuestión se vuelve un poco más compleja. Como un proceso concurrente funciona independientemente de su padre o hermanos, puede resultarle difícil razonar sobre qué es lo correcto hacer con el error. Echa un vistazo al siguiente código para ver un ejemplo de esta cuestión:

checkStatus:=func(done<-chaninterface{},urls...string,)<-chan*http.Response{responses:=make(chan*http.Response)gofunc(){deferclose(responses)for_,url:=rangeurls{resp,err:=http.Get(url)iferr!=nil{fmt.Println(err)continue}select{case<-done:returncaseresponses<-resp:}}}()returnresponses}done:=make(chaninterface{})deferclose(done)urls:=[]string{"https://www.google.com","https://badhost"}forresponse:=rangecheckStatus(done,urls...){fmt.Printf("Response: %v\n",response.Status)}

Aquí vemos a la goroutina haciendo todo lo posible para señalar que hay un error. ¿Qué más puede hacer? ¡No puede devolverlo! ¿Cuántos errores son demasiados? ¿Sigue haciendo peticiones?

La ejecución de este código produce:

Response: 200 OK Get https://badhost: dial tcp: lookup badhost on 127.0.1.1:53: no such host

Aquí vemos que a la goroutina no se le ha dado ninguna opción. No puede tragarse el error, así que hace lo único sensato: imprime el error y espera que alguien le preste atención. No pongas a tus goroutines en esta situación incómoda. Te sugiero que separes tus preocupaciones: en general, tus procesos concurrentes deberían enviar sus errores a otra parte de tu programa que tenga información completa sobre el estado de tu programa, y pueda tomar una decisión más informada sobre qué hacer. El siguiente ejemplo demuestra una solución correcta a este problema:

typeResultstruct{ErrorerrorResponse*http.Response}checkStatus:=func(done<-chaninterface{},urls...string)<-chanResult{results:=make(chanResult)gofunc(){deferclose(results)for_,url:=rangeurls{varresultResultresp,err:=http.Get(url)result=Result{Error:err,Response:resp}select{case<-done:returncaseresults<-result:}}}()returnresults}

done:=make(chaninterface{})deferclose(done)urls:=[]string{"https://www.google.com","https://badhost"}forresult:=rangecheckStatus(done,urls...){ifresult.Error!=nil{fmt.Printf("error: %v",result.Error)continue}fmt.Printf("Response: %v\n",result.Response.Status)}

Aquí creamos un tipo que engloba tanto el

*http.Responsecomo elerrorposibles de una iteración del bucle dentro de nuestra goroutine.

Esta línea devuelve un canal del que se puede leer para recuperar los resultados de una iteración de nuestro bucle.

Aquí creamos una instancia de

Resultcon los camposErroryResponsedefinidos.

Aquí es donde escribimos el

Resulta nuestro canal.

Aquí, en nuestra gorutina principal, podemos tratar los errores que salen de la gorutina iniciada por

checkStatusde forma inteligente, y con el contexto completo del programa más amplio.

Este código produce:

Response: 200 OK error: Get https://badhost: dial tcp: lookup badhost on 127.0.1.1:53: no such host

Lo fundamental aquí es cómo hemos acoplado el resultado potencial con el error potencial. Esto representa el conjunto completo de posibles resultados creados a partir de la gorutina checkStatus, y permite a nuestra gorutina principal tomar decisiones sobre qué hacer cuando se producen errores. En términos más generales, hemos separado con éxito las preocupaciones de la gestión de errores de nuestra goroutina productora. Esto es deseable porque la goroutina que generó la goroutina productora -en este caso nuestra goroutina principal- tiene más contexto sobre el programa en ejecución y puede tomar decisiones más inteligentes sobre qué hacer con los errores.

En el ejemplo anterior, simplemente escribimos los errores en stdio, pero podríamos hacer otra cosa. Modifiquemos ligeramente nuestro programa para que deje de intentar comprobar el estado si se producen tres o más errores:

done:=make(chaninterface{})deferclose(done)errCount:=0urls:=[]string{"a","https://www.google.com","b","c","d"}forresult:=rangecheckStatus(done,urls...){ifresult.Error!=nil{fmt.Printf("error: %v\n",result.Error)errCount++iferrCount>=3{fmt.Println("Too many errors, breaking!")break}continue}fmt.Printf("Response: %v\n",result.Response.Status)}

Este código produce este resultado:

error: Get a: unsupported protocol scheme "" Response: 200 OK error: Get b: unsupported protocol scheme "" error: Get c: unsupported protocol scheme "" Too many errors, breaking!

Puedes ver que, como los errores se devuelven desde checkStatus y no se gestionan internamente dentro de la gorutina, la gestión de errores sigue el patrón familiar de Go. Éste es un ejemplo sencillo, pero no es difícil imaginar situaciones en las que la goroutina principal coordina los resultados de varias goroutinas y construye reglas más complejas para continuar o cancelar las goroutinas hijas. Una vez más, la principal conclusión es que los errores deben considerarse ciudadanos de primera clase cuando se construyan los valores que devolverán las goroutinas. Si tu gorutina puede producir errores, esos errores deben estar estrechamente vinculados a tu tipo de resultado y transmitirse a través de las mismas líneas de comunicación, igual que las funciones síncronas normales.

Tuberías

Cuando escribes un programa, probablemente no te sientas y escribes una función larga, ¡al menos eso espero! Construyes abstracciones en forma de funciones, estructuras, métodos, etc. ¿Por qué lo hacemos? En parte para abstraer detalles que no importan para el flujo general, y en parte para poder trabajar en un área del código sin afectar a otras áreas. ¿Alguna vez has tenido que hacer un cambio en un sistema y te has visto obligado a tocar varias áreas sólo para hacer un cambio lógico? Puede que sea porque ese sistema adolece de una mala abstracción.

Una canalización no es más que otra herramienta que puedes utilizar para formar una abstracción en tu sistema. En concreto, es una herramienta muy potente para utilizar cuando tu programa necesita procesar flujos, o lotes de datos. Se cree que la palabra pipeline se utilizó por primera vez en 1856, y probablemente se refería a una línea de tuberías que transportaban líquido de un lugar a otro. Tomamos prestado este término en informática porque también transportamos algo de un lugar a otro: datos. Una tubería no es más que una serie de cosas que reciben datos, realizan una operación con ellos y los devuelven. Llamamos a cada una de estas operaciones una etapa de la cadena.

Al utilizar una canalización, separas las preocupaciones de cada etapa, lo que proporciona numerosas ventajas. Puedes modificar las etapas independientemente unas de otras, puedes mezclar y combinar cómo se combinan las etapas independientemente de la modificación de las etapas, puedes procesar cada etapa de forma concurrente con las etapas anteriores o posteriores, y puedes abrir en abanico o limitar la velocidad de partes de tu canalización. Hablaremos de la distribución en abanico en la sección "Distribución en abanico, distribución en abanico", y de la limitación de velocidad en el Capítulo 5. No tienes que preocuparte de lo que significan estos términos ahora mismo; empecemos de forma sencilla e intentemos construir una etapa de la tubería.

Como ya se ha dicho, una etapa no es más que algo que recibe datos, los transforma y los devuelve. He aquí una función que podría considerarse una etapa de la tubería:

multiply:=func(values[]int,multiplierint)[]int{multipliedValues:=make([]int,len(values))fori,v:=rangevalues{multipliedValues[i]=v*multiplier}returnmultipliedValues}

Esta función toma una porción de enteros con un multiplicador, los recorre multiplicándolos a medida que avanza y devuelve una nueva porción transformada. Parece una función aburrida, ¿verdad? Vamos a crear otra etapa:

add:=func(values[]int,additiveint)[]int{addedValues:=make([]int,len(values))fori,v:=rangevalues{addedValues[i]=v+additive}returnaddedValues}

¡Otra función aburrida! Ésta sólo crea una nueva rebanada y añade un valor a cada elemento. Llegados a este punto, puede que te estés preguntando qué hace que estas dos funciones sean etapas de canalización y no sólo funciones. Probemos a combinarlas:

ints:=[]int{1,2,3,4}for_,v:=rangeadd(multiply(ints,2),1){fmt.Println(v)}

Este código produce:

3 5 7 9

Fíjate en cómo combinamos add y multiply dentro de la cláusula range. Son funciones como con las que trabajas a diario, pero como las hemos construido para que tengan las propiedades de una etapa de canalización, podemos combinarlas para formar una canalización. Eso es interesante; ¿cuáles son las propiedades de una etapa de canalización?

-

Una etapa consume y devuelve el mismo tipo.

-

Un escenario debe ser cosificado2 por el lenguaje para que se pueda pasar de una a otra. Las funciones en Go están reificadas y se ajustan muy bien a este propósito.

Los que estéis familiarizados con la programación funcional quizá estéis asintiendo con la cabeza y pensando en términos como funciones de orden superior y mónadas. De hecho, las etapas de canalización están muy relacionadas con la programación funcional y pueden considerarse un subconjunto de las mónadas. No voy a entrar aquí explícitamente en las mónadas ni en la programación funcional, pero son temas interesantes por derecho propio, y es útil, aunque innecesario, recurrir al conocimiento práctico de ambos temas cuando se trata de entender los pipelines.

Aquí, nuestras etapas add y multiply satisfacen todas las propiedades de una etapa pipeline: ambas consumen una porción de int y devuelven una porción de int, y como Go tiene funciones reificadas, podemos pasar add y multiple de un lado a otro. Estas propiedades dan lugar a las interesantes propiedades de las etapas pipeline que hemos mencionado antes: a saber, resulta muy fácil combinar nuestras etapas a un nivel superior sin modificar las propias etapas.

Por ejemplo, si ahora quisiéramos añadir una etapa adicional a nuestra tubería para multiplicar por dos, simplemente envolveríamos nuestra tubería anterior en una nueva etapa multiply, así:

ints:=[]int{1,2,3,4}for_,v:=rangemultiply(add(multiply(ints,2),1),2){fmt.Println(v)}

La ejecución de este código produce:

6 10 14 18

Fíjate en que hemos podido hacerlo sin escribir una nueva función, modificar ninguna de las existentes ni modificar lo que hacemos con el resultado de nuestra canalización. Quizá estés empezando a ver las ventajas de utilizar el patrón de canalización. Por supuesto, también podríamos escribir este código procedimentalmente:

ints:=[]int{1,2,3,4}for_,v:=rangeints{fmt.Println(2*(v*2+1))}

Inicialmente, esto parece mucho más sencillo, pero como verás a medida que avancemos, el código procedimental no proporciona las mismas ventajas que una canalización cuando se trata de flujos de datos.

¿Te das cuenta de que cada etapa toma un fragmento de datos y devuelve otro? Estas etapas realizan lo que llamamos procesamiento por lotes. Esto significa que operan con trozos de datos a la vez, en lugar de con un valor discreto cada vez. Hay otro tipo de etapa de canalización que realiza un procesamiento de flujo. Esto significa que la etapa recibe y emite un elemento cada vez.

Hay pros y contras en el procesamiento por lotes frente al procesamiento por flujos, que discutiremos dentro de un momento. Por ahora, fíjate en que para que los datos originales permanezcan inalterados, cada etapa tiene que hacer una nueva rebanada de igual longitud para almacenar los resultados de sus cálculos. Eso significa que la huella de memoria de nuestro programa en un momento dado es el doble del tamaño de la rebanada que enviamos al inicio de nuestro pipeline. Convirtamos nuestras etapas para que estén orientadas al flujo y veamos qué aspecto tiene:

multiply:=func(value,multiplierint)int{returnvalue*multiplier}add:=func(value,additiveint)int{returnvalue+additive}ints:=[]int{1,2,3,4}for_,v:=rangeints{fmt.Println(multiply(add(multiply(v,2),1),2))}

Este código produce:

6 10 14 18

Cada etapa recibe y emite un valor discreto, y la huella de memoria de nuestro programa vuelve a ser sólo del tamaño de la entrada de la tubería. Pero tuvimos que arrastrar la tubería al cuerpo del bucle for y dejar que range hiciera el trabajo pesado de alimentar nuestra tubería. Esto no sólo limita la reutilización de cómo alimentamos la tubería, sino que, como veremos más adelante en esta sección, también limita nuestra capacidad de escalado. También tenemos otros problemas. En efecto, estamos instanciando nuestra canalización en cada iteración del bucle. Aunque es barato hacer llamadas a funciones, estamos haciendo tres llamadas a funciones por cada iteración del bucle. ¿Y qué pasa con la concurrencia? Antes dije que una de las ventajas de utilizar canalizaciones era la posibilidad de procesar etapas individuales de forma concurrente, y mencioné algo sobre el fan-out. ¿Dónde entra todo eso?

Probablemente podría ampliar un poco más nuestras funciones multiply y add para introducir estos conceptos, pero ya han cumplido su función de introducir el concepto de canalización. Es hora de empezar a aprender cuáles son las buenas prácticas para construir canalizaciones en Go, y esto empieza con la primitiva canal de Go.

Buenas prácticas para la construcción de tuberías

Los canales son especialmente adecuados para construir canalizaciones en Go porque cumplen todos nuestros requisitos básicos. Pueden recibir y emitir valores, se pueden utilizar de forma concurrente con seguridad, se pueden recorrer y están reificados por el lenguaje. Tomémonos un momento y convirtamos el ejemplo anterior para utilizar canales en su lugar:

generator:=func(done<-chaninterface{},integers...int)<-chanint{intStream:=make(chanint)gofunc(){deferclose(intStream)for_,i:=rangeintegers{select{case<-done:returncaseintStream<-i:}}}()returnintStream}multiply:=func(done<-chaninterface{},intStream<-chanint,multiplierint,)<-chanint{multipliedStream:=make(chanint)gofunc(){deferclose(multipliedStream)fori:=rangeintStream{select{case<-done:returncasemultipliedStream<-i*multiplier:}}}()returnmultipliedStream}add:=func(done<-chaninterface{},intStream<-chanint,additiveint,)<-chanint{addedStream:=make(chanint)gofunc(){deferclose(addedStream)fori:=rangeintStream{select{case<-done:returncaseaddedStream<-i+additive:}}}()returnaddedStream}done:=make(chaninterface{})deferclose(done)intStream:=generator(done,1,2,3,4)pipeline:=multiply(done,add(done,multiply(done,intStream,2),1),2)forv:=rangepipeline{fmt.Println(v)}

Este código produce:

6 10 14 18

Parece que hemos replicado el resultado deseado, pero a costa de tener mucho más código. ¿Qué hemos ganado exactamente? En primer lugar, examinemos lo que hemos escrito. Ahora tenemos tres funciones en lugar de dos. Parece que todas ellas inician una gorutina dentro de sus cuerpos, y utilizan el patrón que establecimos en "Evitar las fugas de gorutinas" de tomar un canal para indicar que la gorutina debe salir. Todas parece que devuelven canales, y algunas parece que también toman un canal adicional. ¡Interesante! Empecemos a desglosar esto un poco más:

done:=make(chaninterface{})deferclose(done)

Lo primero que hace nuestro programa es crear un canal done y llamar a close en una sentencia defer. Como ya hemos dicho, esto garantiza que nuestro programa salga limpiamente y nunca filtre goroutines. Nada nuevo. A continuación, echemos un vistazo a la función generator:

generator:=func(done<-chaninterface{},integers...int)<-chanint{intStream:=make(chanint)gofunc(){deferclose(intStream)for_,i:=rangeintegers{select{case<-done:returncaseintStream<-i:}}}()returnintStream}// ...intStream:=generator(done,1,2,3,4)

La función generator toma una porción variádica de enteros, construye un canal de enteros con una longitud igual a la porción de enteros entrante, inicia una gorutina y devuelve el canal construido. A continuación, en la goroutina que se creó, generator recorre la porción variádica que se pasó y envía los valores de las porciones por el canal que creó.

Observa que el envío en el canal comparte una sentencia select con una selección en el canal done. De nuevo, éste es el patrón que establecimos en "Prevención de fug as de goroutinas " para evitar fugas de goroutinas.

En pocas palabras, la función generator convierte un conjunto discreto de valores en un flujo de datos en un canal. Acertadamente, este tipo de función se denomina generador. Lo verás con frecuencia cuando trabajes con canalizaciones, porque al principio de la canalización siempre tendrás algún lote de datos que necesites convertir en un canal. Dentro de un rato veremos algunos ejemplos de generadores divertidos, pero antes terminemos el análisis de este programa. A continuación, construimos nuestra canalización:

pipeline:=multiply(done,add(done,multiply(done,intStream,2),1),2)

Es el mismo proceso con el que hemos estado trabajando todo el tiempo: para un flujo de números, los multiplicaremos por dos, sumaremos uno y multiplicaremos el resultado por dos. Esta cadena es similar a nuestra cadena que utiliza funciones en el ejemplo anterior, pero es diferente en aspectos muy importantes.

En primer lugar, estamos utilizando canales. Esto es obvio pero significativo porque permite dos cosas: al final de nuestro pipeline, podemos utilizar una sentencia range para extraer los valores, y en cada etapa podemos ejecutar de forma concurrente con seguridad porque nuestras entradas y salidas son seguras en contextos concurrentes.

Lo que nos lleva a nuestra segunda diferencia: cada etapa del pipeline se ejecuta concurrentemente. Esto significa que cualquier etapa sólo necesita esperar sus entradas, y poder enviar sus salidas. Esto tiene enormes ramificaciones , como descubriremos en la sección "Fan-Out, Fan-In", pero por ahora podemos limitarnos a señalar que permite que nuestras etapas se ejecuten independientemente unas de otras durante cierto tiempo.

Por último, en nuestro ejemplo, recorremos esta tubería y los valores son arrastrados por el sistema:

forv:=rangepipeline{fmt.Println(v)}

Aquí tienes una tabla que muestra cómo cada uno de los valores del sistema entrará en cada canal, y cuándo se cerrarán los canales. La iteración es el recuento base-cero de en qué iteración del bucle for estamos, y el valor de cada columna es el valor tal y como entra en la etapa de canalización:

| Iteración | Generador | Multiplica | Añade | Multiplica | Valor |

|---|---|---|---|---|---|

0 |

1 |

||||

0 |

1 |

||||

0 |

2 |

2 |

|||

0 |

2 |

3 |

|||

0 |

3 |

4 |

6 |

||

1 |

3 |

5 |

|||

1 |

4 |

6 |

10 |

||

2 |

(cerrado) |

4 |

7 |

||

2 |

(cerrado) |

8 |

14 |

||

3 |

(cerrado) |

9 |

|||

3 |

(cerrado) |

18 |

Examinemos también más de cerca nuestro uso del patrón para indicar a las goroutines que salgan. Cuando tratamos con múltiples goroutines interdependientes, ¿cómo acaba funcionando este patrón? ¿Qué pasaría si llamáramos a close en el canal done antes de que el programa terminara de ejecutarse?

Para responder a estas preguntas, echemos un vistazo una vez más a la construcción de nuestra tubería:

pipeline:=multiply(done,add(done,multiply(done,intStream,2),1),2)

Las etapas están interconectadas de dos formas: por el canal común done, y por los canales que se pasan a etapas posteriores de la tubería. En otras palabras, el canal creado por la función multiply se pasa a la función add, y así sucesivamente. Volvamos a la tabla anterior y, antes de permitir que se complete, llamemos a close en el canal done y veamos qué ocurre:

| Iteración | Generador | Multiplica | Añade | Multiplica | Valor |

|---|---|---|---|---|---|

0 |

1 |

||||

0 |

1 |

||||

0 |

2 |

2 |

|||

0 |

2 |

3 |

|||

1 |

3 |

4 |

6 |

||

cerrar(hecho) |

(cerrado) |

3 |

5 |

||

(cerrado) |

6 |

||||

(cerrado) |

7 |

||||

(cerrado) |

|||||

(rango de salida) |

¿Ves cómo el cierre del canal done se produce en cascada a través de la tubería? Esto es posible gracias a dos cosas en cada etapa de la tubería:

-

Alcance sobre el canal entrante. Cuando se cierre el canal entrante, saldrá el alcance.

-

El envío que comparte una declaración

selectcon el canaldone.

Independientemente del estado en que se encuentre la etapa de canalización -esperando en el canal de entrada, o esperando en el canal de envío-, el cierre del canal done forzará la finalización de la etapa de canalización.

Aquí entra en juego una relación de recurrencia. Al principio de la cadena, hemos establecido que debemos convertir valores discretos en un canal. Hay dos puntos en este proceso que deben ser prevenibles:

-

Creación del valor discreto que no es casi instantánea.

-

Envío del valor discreto en su canal.

La primera depende de ti. En nuestro ejemplo, en la función generator, los valores discretos se generan recorriendo la rebanada variádica, lo cual es lo suficientemente instantáneo como para que no necesite ser prevenible. La segunda se gestiona a través de nuestra sentencia select y el canal done, que garantiza que generator sea preferente aunque se bloquee al intentar escribir en intStream.

En el otro extremo de la cadena, la etapa final tiene garantizada la previsibilidad por inducción. Es preferible porque el canal sobre el que nos movemos se cerrará cuando sea preferible, y por tanto nuestro alcance se romperá cuando esto ocurra. La etapa final es preferible porque el flujo del que dependemos es preferible.

Entre el principio y el final de la canalización, el código siempre está recorriendo un canal y enviando por otro canal dentro de una declaración select que contiene un canal done.

Si una etapa se bloquea al recuperar un valor del canal entrante, se desbloqueará cuando ese canal se cierre. Sabemos por inducción que el canal se cerrará porque, o bien es una etapa escrita como la etapa en la que estamos, o bien el comienzo de la tubería que hemos establecido es preferible. Si una etapa se bloquea al enviar un valor, es preemptable gracias a la declaración select.

De este modo, todo nuestro pipeline siempre se puede anticipar cerrando el canal done. Genial, ¿verdad?

Algunos generadores útiles

Antes prometí que hablaría de algunos generadores divertidos que podrían ser de gran utilidad. Como recordatorio, un generador para una canalización es cualquier función que convierte un conjunto de valores discretos en un flujo de valores en un canal. Echemos un vistazo a un generador llamado repeat:

repeat:=func(done<-chaninterface{},values...interface{},)<-chaninterface{}{valueStream:=make(chaninterface{})gofunc(){deferclose(valueStream)for{for_,v:=rangevalues{select{case<-done:returncasevalueStream<-v:}}}}()returnvalueStream}

Esta función repetirá infinitamente los valores que le pases hasta que le digas que se detenga. Echemos un vistazo a otra etapa genérica de la tubería que resulta útil cuando se utiliza en combinación con repeat, take:

take:=func(done<-chaninterface{},valueStream<-chaninterface{},numint,)<-chaninterface{}{takeStream:=make(chaninterface{})gofunc(){deferclose(takeStream)fori:=0;i<num;i++{select{case<-done:returncasetakeStream<-<-valueStream:}}}()returntakeStream}

Esta etapa de canalización sólo tomará los primeros elementos num de su valueStream entrante y luego saldrá. Juntas, ambas pueden ser muy potentes:

done:=make(chaninterface{})deferclose(done)fornum:=rangetake(done,repeat(done,1),10){fmt.Printf("%v ",num)}

La ejecución de este código produce:

1 1 1 1 1 1 1 1 1 1

En este ejemplo básico, creamos un generador repeat para generar un número infinito de unos, pero luego sólo tomamos los 10 primeros. Como el envío del generador repeat se bloquea en la recepción de la etapa take, el generador repeat es muy eficiente. Aunque tenemos la capacidad de generar un flujo infinito de unos, sólo generamos N+1 instancias en las que N es el número que pasamos a la etapa take.

Podemos ampliar esto. Vamos a crear otro generador repetitivo, pero esta vez, vamos a crear uno que llame repetidamente a una función. Llamémoslo repeatFn:

repeatFn:=func(done<-chaninterface{},fnfunc()interface{},)<-chaninterface{}{valueStream:=make(chaninterface{})gofunc(){deferclose(valueStream)for{select{case<-done:returncasevalueStream<-fn():}}}()returnvalueStream}

Utilicémoslo para generar 10 números aleatorios:

done:=make(chaninterface{})deferclose(done)rand:=func()interface{}{returnrand.Int()}fornum:=rangetake(done,repeatFn(done,rand),10){fmt.Println(num)}

Esto produce:

5577006791947779410 8674665223082153551 6129484611666145821 4037200794235010051 3916589616287113937 6334824724549167320 605394647632969758 1443635317331776148 894385949183117216 2775422040480279449

Eso está muy bien: ¡un canal infinito de números enteros aleatorios generados según las necesidades!

Quizá te preguntes por qué todos estos generadores y etapas reciben y envían en canales de interface{}. Podríamos haber escrito estas funciones para que fueran específicas de un tipo, o quizá haber escrito un generador Go.

Las interfaces vacías son un poco tabú en Go, pero para las etapas de canalización opino que está bien tratar en canales de interface{} para que puedas utilizar una biblioteca estándar de patrones de canalización. Como hemos dicho antes, gran parte de la utilidad de una tubería proviene de las etapas reutilizables. Esto se consigue mejor cuando las etapas funcionan al nivel de especificidad adecuado para sí mismas. En los generadores repeat y repeatFn, la preocupación es generar un flujo de datos haciendo un bucle sobre una lista o un operador. Con la etapa take, la preocupación es limitar nuestra tubería. Ninguna de estas operaciones requiere información sobre los tipos con los que trabajan, sino que sólo requieren conocer la aridad de sus parámetros.

Cuando necesites tratar con tipos específicos, puedes colocar una etapa que realice la aserción de tipo por ti. La sobrecarga de rendimiento de tener una etapa de canalización adicional (y, por tanto, una gorutina) y la afirmación de tipo es insignificante, como veremos dentro de un momento. He aquí un pequeño ejemplo que introduce una etapa de canalización toString:

toString:=func(done<-chaninterface{},valueStream<-chaninterface{},)<-chanstring{stringStream:=make(chanstring)gofunc(){deferclose(stringStream)forv:=rangevalueStream{select{case<-done:returncasestringStream<-v.(string):}}}()returnstringStream}

Y un ejemplo de cómo utilizarlo:

done:=make(chaninterface{})deferclose(done)varmessagestringfortoken:=rangetoString(done,take(done,repeat(done,"I","am."),5)){message+=token}fmt.Printf("message: %s...",message)

Este código produce:

message: Iam.Iam.I...

Así que vamos a demostrarnos a nosotros mismos que el coste de rendimiento de generar partes de nuestro pipeline es insignificante. Escribiremos dos funciones de evaluación comparativa: una para probar las etapas genéricas y otra para probar las etapas de tipo específico:

funcBenchmarkGeneric(b*testing.B){done:=make(chaninterface{})deferclose(done)b.ResetTimer()forrangetoString(done,take(done,repeat(done,"a"),b.N)){}}funcBenchmarkTyped(b*testing.B){repeat:=func(done<-chaninterface{},values...string)<-chanstring{valueStream:=make(chanstring)gofunc(){deferclose(valueStream)for{for_,v:=rangevalues{select{case<-done:returncasevalueStream<-v:}}}}()returnvalueStream}take:=func(done<-chaninterface{},valueStream<-chanstring,numint,)<-chanstring{takeStream:=make(chanstring)gofunc(){deferclose(takeStream)fori:=num;i>0||i==-1;{ifi!=-1{i--}select{case<-done:returncasetakeStream<-<-valueStream:}}}()returntakeStream}done:=make(chaninterface{})deferclose(done)b.ResetTimer()forrangetake(done,repeat(done,"a"),b.N){}}

Y los resultados de ejecutar este código son

BenchmarkGeneric-4 |

1000000 |

2266 |

ns/op |

Punto de referenciaTipo-4 |

1000000 |

1181 |

ns/op |

PASE |

|||

ok |

argumentos de la línea de comandos |

3.486s |

Puedes ver que las etapas específicas de tipo son el doble de rápidas, pero sólo marginalmente más rápidas en magnitud. Generalmente, el factor limitante de tu canalización será tu generador o una de las etapas que sea intensiva en cálculo. Si el generador no está creando un flujo desde la memoria, como ocurre con los generadores repeat y repeatFn, probablemente estarás limitado por la E/S. La lectura desde el disco o la red probablemente eclipse la escasa sobrecarga de rendimiento que se muestra aquí.

Si una de tus etapas es costosa desde el punto de vista computacional, esto sin duda eclipsará esta sobrecarga de rendimiento. Si esta técnica te sigue dejando mal sabor de boca, siempre puedes escribir un generador Go para crear tus etapas generadoras. Hablando de que una etapa sea costosa computacionalmente, ¿cómo podemos ayudar a mitigarlo? ¿No limitará la velocidad de toda la tubería?

Para ayudar a mitigarlo, vamos a hablar de la técnica fan-out, fan-in.

Fan-Out, Fan-In

Así que tienes un pipeline montado. Los datos fluyen por tu sistema maravillosamente, transformándose a medida que avanzan por las etapas que has encadenado. Es como un hermoso arroyo; un hermoso y lento arroyo, y oh Dios mío, ¿por qué tarda tanto?

A veces, las etapas de tu canalización pueden ser especialmente costosas desde el punto de vista computacional. Cuando esto ocurre, las etapas anteriores de tu canalización pueden bloquearse mientras esperan a que se completen tus etapas caras. No sólo eso, sino que la propia cadena puede tardar mucho tiempo en ejecutarse en su conjunto. ¿Cómo podemos solucionar esto?

Una de las propiedades interesantes de las canalizaciones es la capacidad que te dan de operar sobre el flujo de datos utilizando una combinación de etapas separadas, a menudo reordenables. Incluso puedes reutilizar etapas de la canalización varias veces. ¿No sería interesante reutilizar una sola etapa de nuestro pipeline en múltiples goroutines en un intento de paralelizar las extracciones de una etapa anterior? Tal vez eso ayudaría a mejorar el rendimiento de la tubería.

De hecho, resulta que sí puede, y este patrón tiene un nombre: fan-out, fan-in.

Fan-out es un término para describir el proceso de iniciar múltiples goroutines para manejar la entrada del pipeline, y fan-in es un término para describir el proceso de combinar múltiples resultados en un canal.

Entonces, ¿qué hace que una etapa de un pipeline sea adecuada para utilizar este patrón? Podrías considerar la posibilidad de desplegar una de tus etapas si se dan las dos circunstancias siguientes:

-

No se basa en valores que la etapa hubiera calculado antes.

-

Tarda mucho en funcionar.

La propiedad de independencia del orden es importante porque no tienes ninguna garantía de en qué orden se ejecutarán las copias concurrentes de tu etapa, ni en qué orden volverán.

Veamos un ejemplo. En el siguiente ejemplo, he construido una forma muy ineficiente de encontrar primos. Utilizaremos muchas de las etapas que creamos en "Tuberías":

rand:=func()interface{}{returnrand.Intn(50000000)}done:=make(chaninterface{})deferclose(done)start:=time.Now()randIntStream:=toInt(done,repeatFn(done,rand))fmt.Println("Primes:")forprime:=rangetake(done,primeFinder(done,randIntStream),10){fmt.Printf("\t%d\n",prime)}fmt.Printf("Search took: %v",time.Since(start))

Aquí tienes los resultados de ejecutar este código:

Primes:

24941317

36122539

6410693

10128161

25511527

2107939

14004383

7190363

45931967

2393161

Search took: 23.437511647s

Estamos generando un flujo de números aleatorios, con un tope de 50.000.000, convirtiendo el flujo en un flujo de números enteros, y pasándolo a continuación a nuestra etapa primeFinder. primeFinder empieza ingenuamente a intentar dividir el número proporcionado en el flujo de entrada por todos los números inferiores. Si no lo consigue, pasa el valor a la siguiente etapa. Ciertamente, ésta es una forma horrible de intentar encontrar números primos, pero cumple nuestro requisito de tardar mucho tiempo.

En nuestro bucle for, recorremos los números primos encontrados, los imprimimos a medida que van llegando y -gracias a nuestra etapa take - cerramos el canal después de encontrar 10 números primos. A continuación, imprimimos el tiempo que ha durado la búsqueda, y el canal done se cierra mediante una sentencia defer y la tubería se descompone.

Para evitar duplicados en nuestros resultados, podríamos introducir otra etapa en nuestro proceso para almacenar en caché los números primos que se han encontrado en un conjunto, pero por simplicidad, los ignoraremos.

Puedes ver que tardó unos 23 segundos en encontrar 10 primos. No está muy bien. Normalmente, primero miraríamos el algoritmo en sí, quizá cogiendo un libro de cocina de algoritmos, y veríamos si podemos mejorar las cosas en cada etapa. Pero como la finalidad de esta etapa es ser lenta, veremos cómo podemos ampliar una o varias etapas para masticar las operaciones lentas más rápidamente.

Éste es un ejemplo relativamente sencillo, por lo que sólo tenemos dos etapas: la generación de números aleatorios y el cribado de primos. En un programa más grande, tu pipeline podría estar compuesto por muchas más etapas; ¿cómo sabemos cuál de ellas hay que separar? Recuerda nuestros criterios anteriores: independencia del orden y duración. Nuestro generador de números enteros aleatorios es ciertamente independiente del orden, pero no tarda mucho tiempo en ejecutarse. La etapa primeFinder también es independiente del orden -los números son primos o no- y, debido a nuestro algoritmo ingenuo, tarda mucho tiempo en ejecutarse. Parece un buen candidato para el abanico.

Afortunadamente, el proceso de abanicar una etapa en un pipeline es extraordinariamente fácil. Todo lo que tenemos que hacer es iniciar varias versiones de esa etapa. Así, en lugar de esto

primeStream:=primeFinder(done,randIntStream)

Podemos hacer algo así

numFinders:=runtime.NumCPU()finders:=make([]<-chanint,numFinders)fori:=0;i<numFinders;i++{finders[i]=primeFinder(done,randIntStream)}

Aquí estamos arrancando tantas copias de esta etapa como CPUs tengamos. En mi ordenador, runtime.NumCPU() devuelve ocho, así que seguiré utilizando este número en nuestra discusión. En producción, probablemente haríamos algunas pruebas empíricas para determinar el número óptimo de CPUs, pero aquí seguiremos siendo sencillos y supondremos que una CPU se mantendrá ocupada por una sola copia de la etapa findPrimes.

Y ya está. Ahora tenemos ocho goroutines que tiran del generador de números aleatorios e intentan determinar si el número es primo. Generar números aleatorios no debería llevar mucho tiempo, por lo que cada goroutina de la etapa findPrimes debería poder determinar si su número es primo y disponer inmediatamente de otro número aleatorio.

Pero seguimos teniendo un problema: ahora que tenemos cuatro goroutines, también tenemos cuatro canales, pero nuestro rango sobre primos sólo espera un canal. Esto nos lleva a la parte de abanico del patrón.

Como ya hemos dicho antes, abrir en abanico significa multiplexar o unir varios flujos de datos en uno solo. El algoritmo para hacerlo es relativamente sencillo:

fanIn:=func(done<-chaninterface{},channels...<-chaninterface{},)<-chaninterface{}{varwgsync.WaitGroupmultiplexedStream:=make(chaninterface{})multiplex:=func(c<-chaninterface{}){deferwg.Done()fori:=rangec{select{case<-done:returncasemultiplexedStream<-i:}}}// Select from all the channelswg.Add(len(channels))for_,c:=rangechannels{gomultiplex(c)}// Wait for all the reads to completegofunc(){wg.Wait()close(multiplexedStream)}()returnmultiplexedStream}

Aquí tomamos nuestro canal estándar

donepara permitir que nuestras goroutines se derrumben, y luego un trozo variado de canalesinterface{}para que se abran en abanico.

En esta línea creamos un

sync.WaitGrouppara poder esperar hasta que se hayan vaciado todos los canales.

Aquí creamos una función,

multiplex, que, cuando se le pasa un canal, leerá del canal, y pasará el valor leído al canalmultiplexedStream.

Esta línea incrementa el

sync.WaitGroupen el número de canales que estamos multiplexando.

Aquí creamos una goroutina para esperar a que se vacíen todos los canales que estamos multiplexando para poder cerrar el canal

multiplexedStream.

En pocas palabras, abrir en abanico implica crear el canal multiplexado del que leerán los consumidores, y luego poner en marcha una goroutina para cada canal entrante, y una goroutina para cerrar el canal multiplexado cuando se hayan cerrado todos los canales entrantes. Como vamos a crear una goroutina que está esperando a que se completen otras goroutinas en N, tiene sentido crear un sync.WaitGroup para coordinar las cosas. La función multiplex también notifica a la WaitGroup que ha terminado.

Juntemos todo esto y veamos si obtenemos alguna disminución en el tiempo de ejecución:

done:=make(chaninterface{})deferclose(done)start:=time.Now()rand:=func()interface{}{returnrand.Intn(50000000)}randIntStream:=toInt(done,repeatFn(done,rand))numFinders:=runtime.NumCPU()fmt.Printf("Spinning up %d prime finders.\n",numFinders)finders:=make([]<-chaninterface{},numFinders)fmt.Println("Primes:")fori:=0;i<numFinders;i++{finders[i]=primeFinder(done,randIntStream)}forprime:=rangetake(done,fanIn(done,finders...),10){fmt.Printf("\t%d\n",prime)}fmt.Printf("Search took: %v",time.Since(start))

Aquí tienes los resultados:

Spinning up 8 prime finders.

Primes:

6410693

24941317

10128161

36122539

25511527

2107939

14004383

7190363

2393161

45931967

Search took: 5.438491216s

Así que de ~23 segundos a ~5 segundos, ¡no está mal! Esto demuestra claramente las ventajas del patrón fan-out, fan-in, y reitera la utilidad de los pipelines. Hemos reducido nuestro tiempo de ejecución en un ~78% sin alterar drásticamente la estructura de nuestro programa.

El canal or-done

A veces trabajarás con canales de partes dispares de tu sistema. A diferencia de lo que ocurre con las canalizaciones, no puedes hacer afirmaciones sobre cómo se comportará un canal cuando el código con el que estás trabajando se cancele a través de su canal done. Es decir, no sabes si el hecho de que se haya cancelado tu goroutina significa que se habrá cancelado el canal del que estás leyendo. Por esta razón, tal y como expusimos en "Evitar las fugas de goroutinas", tenemos que envolver nuestra lectura del canal con una sentencia select que también seleccione de un canal done. Esto está perfectamente bien, pero hacerlo requiere un código que se lee fácilmente así:

forval:=rangemyChan{// Do something with val}

Y lo explota en esto:

loop:for{select{case<-done:breakloopcasemaybeVal,ok:=<-myChan:ifok==false{return// or maybe break from for}// Do something with val}}

Esto puede complicarse rápidamente, sobre todo si tienes bucles anidados. Siguiendo con el tema de utilizar goroutines para escribir código concurrente más claro, y no optimizar prematuramente, podemos solucionar esto con una sola goroutine. Encapsulamos la verbosidad para que otros no tengan que hacerlo:

orDone:=func(done,c<-chaninterface{})<-chaninterface{}{valStream:=make(chaninterface{})gofunc(){deferclose(valStream)for{select{case<-done:returncasev,ok:=<-c:ifok==false{return}select{casevalStream<-v:case<-done:}}}}()returnvalStream}

Hacer esto nos permite volver a los bucles sencillos de for, así:

forval:=rangeorDone(done,myChan){// Do something with val}

Puede que encuentres casos de perímetro en tu código en los que necesites un bucle cerrado utilizando una serie de sentencias select, pero te animo a que intentes primero la legibilidad y evites una optimización prematura.

El canal en T

A veces puedes querer dividir los valores que entran por un canal para enviarlos a dos áreas distintas de tu base de código. Imagina un canal de comandos de usuario: puede que quieras recibir un flujo de comandos de usuario en un canal, enviarlos a algo que los ejecute, y también enviarlos a algo que registre los comandos para su posterior auditoría.

Tomando su nombre del comando tee de los sistemas tipo Unix, el canal-tee hace precisamente esto. Puedes pasarle un canal del que leer, y te devolverá dos canales distintos que obtendrán el mismo valor:

tee:=func(done<-chaninterface{},in<-chaninterface{},)(_,_<-chaninterface{}){<-chaninterface{}){out1:=make(chaninterface{})out2:=make(chaninterface{})gofunc(){deferclose(out1)deferclose(out2)forval:=rangeorDone(done,in){varout1,out2=out1,out2fori:=0;i<2;i++{select{case<-done:caseout1<-val:out1=nilcaseout2<-val:out2=nil}}}}()returnout1,out2}

Querremos utilizar versiones locales de

out1yout2, por lo que sombreamos estas variables.

Vamos a utilizar una sentencia

selectpara que las escrituras enout1yout2no se bloqueen entre sí. Para asegurarnos de que se escribe en ambos, realizaremos dos iteraciones de la sentenciaselect: una para cada canal de salida.

Una vez que hemos escrito en un canal, establecemos su copia oculta en

nilpara que las escrituras posteriores se bloqueen y el otro canal pueda continuar.

Observa que las escrituras en out1 y out2 están estrechamente acopladas. La iteración sobre in no puede continuar hasta que se haya escrito en out1 y out2. Normalmente, esto no es un problema, ya que, de todos modos, gestionar el rendimiento del proceso que lee de cada canal debería ser una preocupación de algo distinto al comando tee, pero merece la pena señalarlo. He aquí un ejemplo rápido para demostrarlo:

done:=make(chaninterface{})deferclose(done)out1,out2:=tee(done,take(done,repeat(done,1,2),4))forval1:=rangeout1{fmt.Printf("out1: %v, out2: %v\n",val1,<-out2)}

Utilizando este patrón, es fácil seguir utilizando canales como puntos de unión de tu sistema.

El puente-canal

En algunas circunstancias, puede que quieras consumir valores de una secuencia de canales:

<-chan <-chan interface{}

Esto es ligeramente diferente de unir una serie de canales en un único canal, como vimos en "El canal or" o "Fan-Out, Fan-In". Una secuencia de canales sugiere una escritura ordenada, aunque de distintas fuentes. Un ejemplo podría ser una etapa de la tubería cuya vida es intermitente. Si seguimos las pautas que establecimos en "Confinamiento" y nos aseguramos de que los canales son propiedad de las goroutinas que escriben en ellos, cada vez que se reinicie una etapa del pipeline dentro de una nueva goroutina, se crearía un nuevo canal. Esto significa que tendríamos efectivamente una secuencia de canales. Exploraremos más este escenario en "Curar goroutinas no sanas".

Como consumidor, al código puede no importarle el hecho de que sus valores procedan de una secuencia de canales. En ese caso, tratar con un canal de canales puede resultar engorroso. En cambio, si definimos una función que pueda desestructurar el canal de canales en un canal simple -una técnica llamada puentear los canales-, al consumidor le resultará mucho más fácil centrarse en el problema que tiene entre manos. He aquí cómo podemos conseguirlo:

bridge:=func(done<-chaninterface{},chanStream<-chan<-chaninterface{},)<-chaninterface{}{valStream:=make(chaninterface{})gofunc(){deferclose(valStream)for{varstream<-chaninterface{}select{casemaybeStream,ok:=<-chanStream:ifok==false{return}stream=maybeStreamcase<-done:return}forval:=rangeorDone(done,stream){select{casevalStream<-val:case<-done:}}}}()returnvalStream}

Este es el canal que devolverá todos los valores de

bridge.

Este bucle se encarga de extraer canales de

chanStreamy proporcionarlos a un bucle anidado para su uso.

Este bucle se encarga de leer los valores del canal que se le ha dado y de repetir esos valores en

valStream. Cuando el flujo sobre el que estamos haciendo el bucle se cierra, salimos del bucle que realiza las lecturas de este canal, y continuamos con la siguiente iteración del bucle, seleccionando canales de los que leer. Esto nos proporciona un flujo ininterrumpido de valores.

Este código es bastante sencillo. Ahora podemos utilizar bridge para ayudar a presentar una fachada de un solo canal sobre un canal de canales. He aquí un ejemplo que crea una serie de 10 canales, cada uno con un elemento escrito en ellos, y pasa estos canales a la función bridge:

genVals:=func()<-chan<-chaninterface{}{chanStream:=make(chan(<-chaninterface{}))gofunc(){deferclose(chanStream)fori:=0;i<10;i++{stream:=make(chaninterface{},1)stream<-iclose(stream)chanStream<-stream}}()returnchanStream}forv:=rangebridge(nil,genVals()){fmt.Printf("%v ",v)}

Ejecutar esto produce:

0 1 2 3 4 5 6 7 8 9

Gracias a bridge, podemos utilizar el canal de canales desde dentro de una única sentencia de rango y centrarnos en la lógica de nuestro bucle. La desestructuración del canal de canales se deja para el código específico de este asunto.

Cola de espera

A veces es útil empezar a aceptar trabajo para tu pipeline aunque éste aún no esté preparado para más. Este proceso se llama poner en cola.

Esto significa que una vez que tu etapa ha completado algún trabajo, lo almacena en una ubicación temporal de la memoria para que otras etapas puedan recuperarlo más tarde, y tu etapa no necesita mantener una referencia a él. En la sección "Canales", hablamos de los canales con búfer, un tipo de cola, pero no hemos hecho mucho uso de ellos desde entonces, y por una buena razón.

Aunque introducir colas en tu sistema es muy útil, suele ser una de las últimas técnicas que quieres emplear al optimizar tu programa. Añadir colas prematuramente puede ocultar problemas de sincronización, como bloqueos muertos y bloqueos vivos, y además, a medida que tu programa converge hacia la corrección, puedes descubrir que necesitas más o menos colas.

Entonces, ¿para qué sirven las colas? Empecemos a responder a esa pregunta abordando uno de los errores más comunes que comete la gente cuando intenta ajustar el rendimiento de un sistema: introducir colas para intentar resolver problemas de rendimiento. Las colas casi nunca acelerarán el tiempo total de ejecución de tu programa; sólo permitirán que el programa se comporte de forma diferente.

Para entender por qué, veamos una tubería sencilla:

done:=make(chaninterface{})deferclose(done)zeros:=take(done,3,repeat(done,0))short:=sleep(done,1*time.Second,zeros)long:=sleep(done,4*time.Second,short)pipeline:=long

Este conducto encadena cuatro etapas:

-

Una etapa de repetición que genera un flujo interminable de 0s.

-

Una etapa que anula las etapas anteriores después de ver tres objetos.

-

Una etapa "corta" que duerme un segundo.

-

Una etapa "larga" que duerme cuatro segundos.

A efectos de este ejemplo, vamos a suponer que las etapas 1 y 2 son instantáneas, y vamos a centrarnos en cómo afectan las etapas que duermen al tiempo de ejecución de la tubería.

Aquí tienes una tabla que examina el tiempo t, la iteración i, y el tiempo que les queda a las etapas larga y corta para pasar a su siguiente valor.

| Tiempo(t) | i | Etapa larga | Etapa corta |

|---|---|---|---|

0 |

0 |

1s |

|

1 |

0 |

4s |

1s |

2 |

0 |

3s |

(bloqueado) |

3 |

0 |

2s |

(bloqueado) |

4 |

0 |

1s |

(bloqueado) |

5 |

1 |

4s |

1s |

6 |

1 |

3s |

(bloqueado) |

7 |

1 |

2s |

(bloqueado) |

8 |

1 |

1s |

(bloqueado) |

9 |

2 |

4s |

(cerrar) |

10 |

2 |

3s |

|

11 |

2 |

2s |

|

12 |

2 |

1s |

|

13 |

3 |

(cerrar) |

Puedes ver que esta tubería tarda aproximadamente 13 segundos en ejecutarse. La etapa corta tarda unos 9 segundos en completarse.

¿Qué ocurre si modificamos la tubería para incluir un búfer? Examinemos la misma tubería con un búfer de 2 introducido entre las etapas larga y corta:

done:=make(chaninterface{})deferclose(done)zeros:=take(done,3,repeat(done,0))short:=sleep(done,1*time.Second,zeros)buffer:=buffer(done,2,short)// Buffers sends from short by 2long:=sleep(done,4*time.Second,short)pipeline:=long

Aquí tienes el tiempo de ejecución:

| Tiempo(t) | i | Etapa larga | Tampón | Etapa corta |

|---|---|---|---|---|

0 |

0 |

0/2 |

1s |

|

1 |

0 |

4s |

0/2 |

1s |

2 |

0 |

3s |

1/2 |

1s |

3 |

0 |

2s |

2/2 |

(cerrar) |

4 |

0 |

1s |

2/2 |

|

5 |

1 |

4s |

1/2 |

|

6 |

1 |

3s |

1/2 |

|

7 |

1 |

2s |

1/2 |

|

8 |

1 |

1s |

1/2 |

|

9 |

2 |

4s |

0/2 |

|

10 |

2 |

3s |

0/2 |

|

11 |

2 |

2s |

0/2 |

|

12 |

2 |

1s |

0/2 |

|

13 |

3 |

(cerrar) |

Aun así, ¡el pipeline completo tardó 13 segundos! Pero fíjate en el tiempo de ejecución de la etapa corta. Sólo tarda 3 segundos en completarse, frente a los 9 segundos que tardaba antes. ¡Hemos reducido el tiempo de ejecución de esta etapa en dos tercios! Pero si toda la cadena sigue tardando 13 segundos en ejecutarse, ¿en qué nos ayuda esto?

Imagina en su lugar la siguiente tubería:

p:=processRequest(done,acceptConnection(done,httpHandler))

Aquí la canalización no sale hasta que se cancela, y la etapa que está aceptando conexiones no deja de aceptar conexiones hasta que se cancela la canalización. En este caso, no querrás que las conexiones a tu programa empiecen a caducar porque tu etapa processRequest esté bloqueando tu etapa acceptConnection. Quieres que tu etapa acceptConnection esté desbloqueada en la medida de lo posible. De lo contrario, los usuarios de tu programa podrían empezar a ver sus peticiones denegadas por completo.

Así que la respuesta a nuestra pregunta sobre la utilidad de introducir una cola no es que se haya reducido el tiempo de ejecución de una de las etapas, sino que se ha reducido el tiempo que está en estado de bloqueo. Esto permite que la etapa siga haciendo su trabajo. En este ejemplo, los usuarios probablemente experimentarían un retraso en sus solicitudes, pero no se les denegaría el servicio por completo.

De este modo, la verdadera utilidad de las colas es desacoplar etapas, de modo que el tiempo de ejecución de una etapa no repercuta en el tiempo de ejecución de otra. Desacoplar etapas de este modo altera en cascada el comportamiento en tiempo de ejecución del sistema en su conjunto, lo que puede ser bueno o malo según tu sistema.

Llegamos entonces a la cuestión de afinar tus colas. ¿Dónde deben colocarse las colas? ¿Cuál debe ser el tamaño del búfer? Las respuestas a estas preguntas dependen de la naturaleza de tu canalización.

Empecemos analizando las situaciones en las que las colas pueden aumentar el rendimiento general de tu sistema. Las únicas situaciones aplicables son:

-

Si la agrupación de solicitudes en una etapa ahorra tiempo.

-

Si los retrasos en una etapa producen un bucle de realimentación en el sistema.

Un ejemplo de la primera situación es una etapa que almacena la entrada en algo más rápido (por ejemplo, la memoria) de lo que está diseñada para enviar (por ejemplo, el disco). Éste es, por supuesto, todo el propósito del paquete bufio de Go. He aquí un ejemplo que demuestra una simple comparación de una escritura con búfer a una cola frente a una escritura sin búfer:

funcBenchmarkUnbufferedWrite(b*testing.B){performWrite(b,tmpFileOrFatal())}funcBenchmarkBufferedWrite(b*testing.B){bufferredFile:=bufio.NewWriter(tmpFileOrFatal())performWrite(b,bufio.NewWriter(bufferredFile))}functmpFileOrFatal()*os.File{file,err:=ioutil.TempFile("","tmp")iferr!=nil{log.Fatal("error: %v",err)}returnfile}funcperformWrite(b*testing.B,writerio.Writer){done:=make(chaninterface{})deferclose(done)b.ResetTimer()forbt:=rangetake(done,repeat(done,byte(0)),b.N){writer.Write([]byte{bt.(byte)})}}

gotest-bench=. src/concurrency-patterns-in-go/queuing/buffering_test.go

Y aquí están los resultados de ejecutar esta prueba comparativa:

Evaluación comparativaUnbufferedWrite-8 |

500000 |

3969 |

ns/op |

PruebaBufferedWrite-8 |

1000000 |

1356 |

ns/op |

PASE |

|||

ok |

argumentos de la línea de comandos |

3.398s |

Como era de esperar, la escritura con búfer es más rápida que la escritura sin búfer. Esto se debe a que en bufio.Writer, las escrituras se ponen en cola internamente en un búfer hasta que se ha acumulado un trozo suficiente, y entonces se escribe el trozo. Por razones obvias, este proceso se denomina "chunking".

La fragmentación es más rápida porque bytes.Buffer debe hacer crecer su memoria asignada para acomodar los bytes que debe almacenar. Por diversas razones, hacer crecer la memoria es caro; por tanto, cuantas menos veces tengamos que hacerla crecer, más eficiente será el rendimiento de nuestro sistema en su conjunto. Así pues, la cola ha aumentado el rendimiento de nuestro sistema en su conjunto.

Éste es sólo un ejemplo sencillo de chunking en memoria, pero es posible que te encuentres con chunking con frecuencia sobre el terreno. Normalmente, cada vez que realizar una operación requiere una sobrecarga, el chunking puede aumentar el rendimiento del sistema. Algunos ejemplos son la apertura de transacciones de bases de datos, el cálculo de sumas de comprobación de mensajes y la asignación de espacio contiguo.

Aparte del chunking, la cola también puede ayudar si tu algoritmo puede optimizarse mediante el soporte de lookbehinds, u ordenación.

El segundo escenario, en el que un retraso en una etapa provoca más entradas en la tubería, es un poco más difícil de detectar, pero también más importante porque puede provocar un colapso sistémico de tus sistemas ascendentes.

Esta idea suele denominarse bucle de retroalimentación negativa, espiral descendente o incluso espiral de la muerte. Esto se debe a que existe una relación recurrente entre la tubería y sus sistemas ascendentes; el ritmo al que las etapas o sistemas ascendentes envían nuevas solicitudes está vinculado de alguna manera a lo eficiente que es la tubería.

Si la eficacia de la tubería cae por debajo de un determinado umbral crítico, los sistemas anteriores a la tubería empiezan a aumentar sus aportaciones a ésta, lo que hace que la tubería pierda más eficacia, y se inicia la espiral de la muerte. Sin algún tipo de mecanismo de seguridad, el sistema que utiliza la tubería nunca se recuperará.